В некоторых случаях исследователь не знает заранее, по какому именно закону распределены наблюдаемые значение исследуемого признака. Но у него могут быть достаточно веские причины предполагать, что распределение подчинено тому или иному закону, например, нормальному или равномерному. В этом случае выдвигаются основная и альтернативная статистические гипотезы следующего вида:

H 0: распределение наблюдаемого признака подчинено закону распределения A ,

H 1: распределение наблюдаемого признака отличается от A ;

где в качестве A может выступать тот или иной закон распределения: нормальный, равномерный, показательный и т. д.

Проверка гипотезы о предполагаемом законе распределения проводится при помощи так называемых критериев согласия. Имеется несколько критериев согласия. Наиболее универсальным из них является -критерий Пирсона, так как он применим к любому виду распределения.

-Критерий Пирсона

Обычно эмпирические и теоретические частоты различаются. Случайно ли расхождение частот? Критерий Пирсона дает ответ на этот вопрос, правда, как и любой статистический критерий, он не доказывает справедливость гипотезы в строго математическом смысле, а лишь устанавливает на определенном уровне значимости ее согласие или несогласие с данными наблюдений.

Итак, пусть по выборке объема получено статистическое распределение значений признака, где- наблюдаемые значения признака,- соответствующие им частоты:

Суть критерия Пирсона состоит в вычислении критерия по следующей формуле:

![]()

где - это число разрядов наблюдаемых значений, а- теоретические частоты соответствующих значений.

Понятно, что чем меньше разности , тем ближе эмпирическое распределение к эмпирическому, поэтому, чем меньше значение критерия, тем с большей достоверностью можно утверждать, что эмпирическое и теоретическое распределение подчинены одному закону.

Алгоритм критерия Пирсона

Алгоритм критерия Пирсона несложен и состоит в выполнении следующих действий:

Итак, единственным нетривиальным действием в этом алгоритме является определение теоретических частот. Они, разумеется, зависят от закона распределения, поэтому - для различных законов определяются по-разному.

|

Достоинством критерия Пирсона является его универсальность: с его помощью можно проверять гипотезы о различных законах распределения.

1. Проверка гипотезы о нормальном распределении.

Пусть получена выборка достаточно большого объема п с большим количеством различных значений вариант. Для удобства ее обработки разделим интервал от наименьшего до наибольшего из значений вариант на s равных частей и будем считать, что значения вариант, попавших в каждый интервал, приближенно равны числу, задающему середину интервала. Подсчитав число вариант, попавших в каждый интервал, составим так называемую сгруппированную выборку:

варианты………..х 1 х 2 … х s

частоты………….п 1 п 2 … п s ,

где х i – значения середин интервалов, а п i – число вариант, попавших в i -й интервал (эмпирические частоты).

По полученным данным можно вычислить выборочное среднее и выборочное среднее квадратическое отклонение σ В . Проверим предположение, что генеральная совокупность распределена по нормальному закону с параметрами M (X ) = , D (X ) = . Тогда можно найти количество чисел из выборки объема п , которое должно оказаться в каждом интервале при этом предположении (то есть теоретические частоты). Для этого по таблице значений функции Лапласа найдем вероятность попадания в i -й интервал:

,

,

где а i и b i - границы i -го интервала. Умножив полученные вероятности на объем выборки п, найдем теоретические частоты: п i =n·p i .Наша цель – сравнить эмпирические и теоретические частоты, которые, конечно, отличаются друг от друга, и выяснить, являются ли эти различия несущественными, не опровергающими гипотезу о нормальном распределении исследуемой случайной величины, или они настолько велики, что противоречат этой гипотезе. Для этого используется критерий в виде случайной величины

![]() . (20.1)

. (20.1)

Смысл ее очевиден: суммируются части, которые квадраты отклонений эмпирических частот от теоретических составляют от соответствующих теоретических частот. Можно доказать, что вне зависимости от реального закона распределения генеральной совокупности закон распределения случайной величины (20.1) при стремится к закону распределения (см. лекцию 12) с числом степеней свободы k = s – 1 – r , где r – число параметров предполагаемого распределения, оцененных по данным выборки. Нормальное распределение характеризуется двумя параметрами, поэтому k = s – 3. Для выбранного критерия строится правосторонняя критическая область, определяемая условием

![]() (20.2)

(20.2)

где α

– уровень значимости. Следовательно, критическая область задается неравенством ![]() а область принятия гипотезы - .

а область принятия гипотезы - .

Итак, для проверки нулевой гипотезы Н 0: генеральная совокупность распределена нормально – нужно вычислить по выборке наблюдаемое значение критерия:

![]() , (20.1`)

, (20.1`)

а по таблице критических точек распределения χ 2 найти критическую точку , используя известные значения α и k = s – 3. Если - нулевую гипотезу принимают, при ее отвергают.

2. Проверка гипотезы о равномерном распределении.

При использовании критерия Пирсона для проверки гипотезы о равномерном распределении генеральной совокупности с предполагаемой плотностью вероятности

необходимо, вычислив по имеющейся выборке значение , оценить параметры а и b по формулам:

где а*

и b*

- оценки а

и b

. Действительно, для равномерного распределения М

(Х

) = , ![]() , откуда можно получить систему для определения а*

и b

*: , решением которой являются выражения (20.3).

, откуда можно получить систему для определения а*

и b

*: , решением которой являются выражения (20.3).

Затем, предполагая, что ![]() , можно найти теоретические частоты по формулам

, можно найти теоретические частоты по формулам

![]()

Здесь s – число интервалов, на которые разбита выборка.

Наблюдаемое значение критерия Пирсона вычисляется по формуле (20.1`), а критическое – по таблице с учетом того, что число степеней свободы k = s – 3. После этого границы критической области определяются так же, как и для проверки гипотезы о нормальном распределении.

3. Проверка гипотезы о показательном распределении.

В этом случае, разбив имеющуюся выборку на равные по длине интервалы, рассмотрим последовательность вариант , равноотстоящих друг от друга (считаем, что все варианты, попавшие в i – й интервал, принимают значение, совпадающее с его серединой), и соответствующих им частот n i (число вариант выборки, попавших в i – й интервал). Вычислим по этим данным и примем в качестве оценки параметра λ величину . Тогда теоретические частоты вычисляются по формуле

Затем сравниваются наблюдаемое и критическое значение критерия Пирсона с учетом того, что число степеней свободы k = s – 2.

Критерий корреляции Пирсона – это метод параметрической статистики, позволяющий определить наличие или отсутствие линейной связи между двумя количественными показателями, а также оценить ее тесноту и статистическую значимость. Другими словами, критерий корреляции Пирсона позволяет определить, есть ли линейная связь между изменениями значений двух переменных. В статистических расчетах и выводах коэффициент корреляции обычно обозначается как r xy или R xy .

1. История разработки критерия корреляции

Критерий корреляции Пирсона был разработан командой британских ученых во главе с Карлом Пирсоном (1857-1936) в 90-х годах 19-го века, для упрощения анализа ковариации двух случайных величин. Помимо Карла Пирсона над критерием корреляции Пирсона работали также Фрэнсис Эджуорт и Рафаэль Уэлдон .

2. Для чего используется критерий корреляции Пирсона?

Критерий корреляции Пирсона позволяет определить, какова теснота (или сила) корреляционной связи между двумя показателями, измеренными в количественной шкале. При помощи дополнительных расчетов можно также определить, насколько статистически значима выявленная связь.

Например, при помощи критерия корреляции Пирсона можно ответить на вопрос о наличии связи между температурой тела и содержанием лейкоцитов в крови при острых респираторных инфекциях, между ростом и весом пациента, между содержанием в питьевой воде фтора и заболеваемостью населения кариесом.

3. Условия и ограничения применения критерия хи-квадрат Пирсона

- Сопоставляемые показатели должны быть измерены в количественной шкале (например, частота сердечных сокращений, температура тела, содержание лейкоцитов в 1 мл крови, систолическое артериальное давление).

- Посредством критерия корреляции Пирсона можно определить лишь наличие и силу линейной взаимосвязи между величинами. Прочие характеристики связи, в том числе направление (прямая или обратная), характер изменений (прямолинейный или криволинейный), а также наличие зависимости одной переменной от другой - определяются при помощи регрессионного анализа .

- Количество сопоставляемых величин должно быть равно двум. В случае анализ взаимосвязи трех и более параметров следует воспользоваться методом факторного анализа .

- Критерий корреляции Пирсона является параметрическим , в связи с чем условием его применения служит нормальное распределение сопоставляемых переменных. В случае необходимости корреляционного анализа показателей, распределение которых отличается от нормального, в том числе измеренных в порядковой шкале, следует использовать коэффициент ранговой корреляции Спирмена .

- Следует четко различать понятия зависимости и корреляции. Зависимость величин обуславливает наличие корреляционной связи между ними, но не наоборот.

Например, рост ребенка зависит от его возраста, то есть чем старше ребенок, тем он выше. Если мы возьмем двух детей разного возраста, то с высокой долей вероятности рост старшего ребенка будет больше, чем у младшего. Данное явление и называется зависимостью , подразумевающей причинно-следственную связь между показателями. Разумеется, между ними имеется и корреляционная связь , означающая, что изменения одного показателя сопровождаются изменениями другого показателя.

В другой ситуации рассмотрим связь роста ребенка и частоты сердечных сокращений (ЧСС). Как известно, обе эти величины напрямую зависят от возраста, поэтому в большинстве случаев дети большего роста (а значит и более старшего возраста) будут иметь меньшие значения ЧСС. То есть, корреляционная связь будет наблюдаться и может иметь достаточно высокую тесноту. Однако, если мы возьмем детей одного возраста , но разного роста , то, скорее всего, ЧСС у них будет различаться несущественно, в связи с чем можно сделать вывод о независимости ЧСС от роста.

Приведенный пример показывает, как важно различать фундаментальные в статистике понятия связи и зависимости показателей для построения верных выводов.

4. Как рассчитать коэффициента корреляции Пирсона?

Расчет коэффициента корреляции Пирсона производится по следующей формуле:

5. Как интерпретировать значение коэффициента корреляции Пирсона?

Значения коэффициента корреляции Пирсона интерпретируются исходя из его абсолютных значений. Возможные значения коэффициента корреляции варьируют от 0 до ±1. Чем больше абсолютное значение r xy – тем выше теснота связи между двумя величинами. r xy = 0 говорит о полном отсутствии связи. r xy = 1 – свидетельствует о наличии абсолютной (функциональной) связи. Если значение критерия корреляции Пирсона оказалось больше 1 или меньше -1 – в расчетах допущена ошибка.

Для оценки тесноты, или силы, корреляционной связи обычно используют общепринятые критерии, согласно которым абсолютные значения r xy < 0.3 свидетельствуют о слабой связи, значения r xy от 0.3 до 0.7 - о связи средней тесноты, значения r xy > 0.7 - о сильной связи.

Более точную оценку силы корреляционной связи можно получить, если воспользоваться таблицей Чеддока :

Оценка статистической значимости коэффициента корреляции r xy осуществляется при помощи t-критерия, рассчитываемого по следующей формуле:

![]()

Полученное значение t r сравнивается с критическим значением при определенном уровне значимости и числе степеней свободы n-2. Если t r превышает t крит, то делается вывод о статистической значимости выявленной корреляционной связи.

6. Пример расчета коэффициента корреляции Пирсона

Целью исследования явилось выявление, определение тесноты и статистической значимости корреляционной связи между двумя количественными показателями: уровнем тестостерона в крови (X) и процентом мышечной массы в теле (Y). Исходные данные для выборки, состоящей из 5 исследуемых (n = 5), сведены в таблице.

Статистический критерий

Правило, по которому гипотеза Я 0 отвергается или принимается, называется статистическим критерием. В названии критерия, как правило, содержится буква, которой обозначается специально составленная характеристика из п. 2 алгоритма проверки статистической гипотезы (см. п. 4.1), рассчитываемая в критерии. В условиях данного алгоритма критерий назывался бы «в -критерий».

При проверке статистических гипотез возможны два типа ошибок:

- - ошибка первого рода (можно отвергнуть гипотезу Я 0 , когда она на самом деле верна);

- - ошибка второго рода (можно принять гипотезу Я 0 , когда она на самом деле не верна).

Вероятность а допустить ошибку первого рода называется уровнем значимости критерия.

Если за р обозначить вероятность допустить ошибку второго рода, то (l - р) - вероятность не допустить ошибку второго рода, которая называется мощностью критерия.

Критерий согласия х 2 Пирсона

Существует несколько типов статистических гипотез:

- - о законе распределения;

- - однородности выборок;

- - численных значениях параметров распределения и т.д.

Мы будем рассматривать гипотезу о законе распределения на примере критерия согласия х 2 Пирсона.

Критерием согласия называют статистический критерий проверки нулевой гипотезы о предполагаемом законе неизвестного распределения.

В основе критерия согласия Пирсона лежит сравнение эмпирических (наблюдаемых) и теоретических частот наблюдений, вычисленных в предположении определенного закона распределения. Гипотеза # 0 здесь формулируется так: по исследуемому признаку генеральная совокупность распределена нормально.

Алгоритм проверки статистической гипотезы # 0 для критерия х 1 Пирсона:

- 1) выдвигаем гипотезу Я 0 - по исследуемому признаку генеральная совокупность распределена нормально;

- 2) вычисляем выборочную среднюю и выборочное среднее квадратическое отклонение о в;

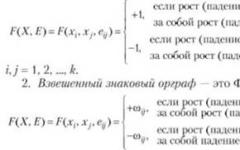

3) по имеющейся выборке объема п рассчитываем специально составленную характеристику ,

где: я, - эмпирические частоты,

- теоретические частоты,

- теоретические частоты,

п - объем выборки,

h - величина интервала (разность между двумя соседними вариантами),

Нормализованные значения наблюдаемого признака,

![]() - табличная функция. Также теоретические частоты

- табличная функция. Также теоретические частоты

могут быть вычислены с помощью стандартной функции MS Excel НОРМРАСП по формуле ;

4) по выборочному распределению определяем критическое значение специально составленной характеристики xl P

5) при гипотеза # 0 отвергается, при гипотеза # 0 принимается.

Пример. Рассмотрим признак X - величину показателей тестирования осужденных в одной из исправительных колоний по некоторой психологической характеристике, представленный в виде вариационного ряда:

На уровне значимости 0,05 проверить гипотезу о нормальном распределении генеральной совокупности.

1. На основе эмпирического распределения можно выдвинуть гипотезу Н 0 : по исследуемому признаку «величина показателя тестирования по данной психологической характеристике» генеральная совокупность осу-

жденных распределена нормально. Альтернативная гипотеза 1: по исследуемому признаку «величина показателя тестирования по данной психологической характеристике» генеральная совокупность осужденных не распределена нормально.

2. Вычислим числовые выборочные характеристики:

|

Интервалы |

х г щ |

х} щ |

|

||||

3. Вычислим специально составленную характеристику j 2 . Для этого в предпоследнем столбце предыдущей таблицы найдем теоретические частоты по формуле , а в последнем столбце

проведем расчет характеристики % 2 . Получаем х 2 = 0,185.

Для наглядности построим полигон эмпирического распределения и нормальную кривую по теоретическим частотам (рис. 6).

Рис. 6.

4. Определим число степеней свободы s : к = 5, т = 2, s = 5-2-1 = 2.

По таблице или с помощью стандартной функции MS Excel «ХИ20БР» для числа степеней свободы 5 = 2 и уровня значимости а = 0,05 найдем критическое значение критерия xl P . =5,99. Для уровня значимости а = 0,01 критическое значение критерия х%. = 9,2.

5. Наблюдаемое значение критерия х =0,185 меньше всех найденных значений Хк Р.-> поэтому гипотеза Я 0 принимается на обоих уровнях значимости. Расхождение эмпирических и теоретических частот незначимое. Следовательно, данные наблюдений согласуются с гипотезой о нормальном распределении генеральной совокупности. Таким образом, по исследуемому признаку «величина показателя тестирования по данной психологической характеристике» генеральная совокупность осужденных распределена нормально.

- 1. Корячко А.В., Куличенко А.Г. Высшая математика и математические методы в психологии: руководство к практическим занятиям для слушателей психологического факультета. Рязань, 1994.

- 2. Наследов А.Д. Математические методы психологического исследования. Анализ и интерпретация данных: Учеб, пособие. СПб., 2008.

- 3. Сидоренко Е.В. Методы математической обработки в психологии. СПб., 2010.

- 4. Сошникова Л.А. и др. Многомерный статистический анализ в экономике: Учеб, пособие для вузов. М., 1999.

- 5. Суходольский Е.В. Математические методы в психологии. Харьков, 2004.

- 6. Шмойлова Р.А., Минашкин В.Е., Садовникова Н.А. Практикум по теории статистики: Учеб, пособие. М., 2009.

- Гмурман В.Е. Теория вероятностей и математическая статистика. С. 465.

Ширина интервала составит:

Xmax - максимальное значение группировочного признака в совокупности.

Xmin - минимальное значение группировочного признака.

Определим границы группы.

| Номер группы | Нижняя граница | Верхняя граница |

| 1 | 43 | 45.83 |

| 2 | 45.83 | 48.66 |

| 3 | 48.66 | 51.49 |

| 4 | 51.49 | 54.32 |

| 5 | 54.32 | 57.15 |

| 6 | 57.15 | 60 |

Одно и тоже значение признака служит верхней и нижней границами двух смежных (предыдущей и последующей) групп.

Для каждого значения ряда подсчитаем, какое количество раз оно попадает в тот или иной интервал. Для этого сортируем ряд по возрастанию.

| 43 | 43 - 45.83 | 1 |

| 48.5 | 45.83 - 48.66 | 1 |

| 49 | 48.66 - 51.49 | 1 |

| 49 | 48.66 - 51.49 | 2 |

| 49.5 | 48.66 - 51.49 | 3 |

| 50 | 48.66 - 51.49 | 4 |

| 50 | 48.66 - 51.49 | 5 |

| 50.5 | 48.66 - 51.49 | 6 |

| 51.5 | 51.49 - 54.32 | 1 |

| 51.5 | 51.49 - 54.32 | 2 |

| 52 | 51.49 - 54.32 | 3 |

| 52 | 51.49 - 54.32 | 4 |

| 52 | 51.49 - 54.32 | 5 |

| 52 | 51.49 - 54.32 | 6 |

| 52 | 51.49 - 54.32 | 7 |

| 52 | 51.49 - 54.32 | 8 |

| 52 | 51.49 - 54.32 | 9 |

| 52.5 | 51.49 - 54.32 | 10 |

| 52.5 | 51.49 - 54.32 | 11 |

| 53 | 51.49 - 54.32 | 12 |

| 53 | 51.49 - 54.32 | 13 |

| 53 | 51.49 - 54.32 | 14 |

| 53.5 | 51.49 - 54.32 | 15 |

| 54 | 51.49 - 54.32 | 16 |

| 54 | 51.49 - 54.32 | 17 |

| 54 | 51.49 - 54.32 | 18 |

| 54.5 | 54.32 - 57.15 | 1 |

| 54.5 | 54.32 - 57.15 | 2 |

| 55.5 | 54.32 - 57.15 | 3 |

| 57 | 54.32 - 57.15 | 4 |

| 57.5 | 57.15 - 59.98 | 1 |

| 57.5 | 57.15 - 59.98 | 2 |

| 58 | 57.15 - 59.98 | 3 |

| 58 | 57.15 - 59.98 | 4 |

| 58.5 | 57.15 - 59.98 | 5 |

| 60 | 57.15 - 59.98 | 6 |

Результаты группировки оформим в виде таблицы:

| Группы | № совокупности | Частота fi |

| 43 - 45.83 | 1 | 1 |

| 45.83 - 48.66 | 2 | 1 |

| 48.66 - 51.49 | 3,4,5,6,7,8 | 6 |

| 51.49 - 54.32 | 9,10,11,12,13,14,15,16,17,18,19,20,21,22,23,24,25,26 | 18 |

| 54.32 - 57.15 | 27,28,29,30 | 4 |

| 57.15 - 59.98 | 31,32,33,34,35,36 | 6 |

Таблица для расчета показателей.

| Группы | x i | Кол-во, f i | x i * f i | Накопленная частота, S | |x - x ср |*f | (x - x ср) 2 *f | Частота, f i /n |

| 43 - 45.83 | 44.42 | 1 | 44.42 | 1 | 8.88 | 78.91 | 0.0278 |

| 45.83 - 48.66 | 47.25 | 1 | 47.25 | 2 | 6.05 | 36.64 | 0.0278 |

| 48.66 - 51.49 | 50.08 | 6 | 300.45 | 8 | 19.34 | 62.33 | 0.17 |

| 51.49 - 54.32 | 52.91 | 18 | 952.29 | 26 | 7.07 | 2.78 | 0.5 |

| 54.32 - 57.15 | 55.74 | 4 | 222.94 | 30 | 9.75 | 23.75 | 0.11 |

| 57.15 - 59.98 | 58.57 | 6 | 351.39 | 36 | 31.6 | 166.44 | 0.17 |

| 36 | 1918.73 | 82.7 | 370.86 | 1 |

Для оценки ряда распределения найдем следующие показатели:

Показатели центра распределения .

Средняя взвешенная

Мода

Мода - наиболее часто встречающееся значение признака у единиц данной совокупности.

где x 0 – начало модального интервала; h – величина интервала; f 2 –частота, соответствующая модальному интервалу; f 1 – предмодальная частота; f 3 – послемодальная частота.

Выбираем в качестве начала интервала 51.49, так как именно на этот интервал приходится наибольшее количество.

Наиболее часто встречающееся значение ряда – 52.8

Медиана

Медиана делит выборку на две части: половина вариант меньше медианы, половина - больше.

В интервальном ряду распределения сразу можно указать только интервал, в котором будут находиться мода или медиана. Медиана соответствует варианту, стоящему в середине ранжированного ряда. Медианным является интервал 51.49 - 54.32, т.к. в этом интервале накопленная частота S, больше медианного номера (медианным называется первый интервал, накопленная частота S которого превышает половину общей суммы частот).

Таким образом, 50% единиц совокупности будут меньше по величине 53.06

Показатели вариации .

Абсолютные показатели вариации .

Размах вариации - разность между максимальным и минимальным значениями признака первичного ряда.

R = X max - X min

R = 60 - 43 = 17

Среднее линейное отклонение - вычисляют для того, чтобы учесть различия всех единиц исследуемой совокупности.

Каждое значение ряда отличается от другого не более, чем на 2.3

Дисперсия - характеризует меру разброса около ее среднего значения (мера рассеивания, т.е. отклонения от среднего).

Несмещенная оценка дисперсии - состоятельная оценка дисперсии.

Среднее квадратическое отклонение .

Каждое значение ряда отличается от среднего значения 53.3 не более, чем на 3.21

Оценка среднеквадратического отклонения .

Относительные показатели вариации .

К относительным показателям вариации относят: коэффициент осцилляции, линейный коэффициент вариации, относительное линейное отклонение.

Коэффициент вариации - мера относительного разброса значений совокупности: показывает, какую долю среднего значения этой величины составляет ее средний разброс.

Поскольку v ≤ 30%, то совокупность однородна, а вариация слабая. Полученным результатам можно доверять.

Линейный коэффициент вариации или Относительное линейное отклонение - характеризует долю усредненного значения признака абсолютных отклонений от средней величины.

Проверка гипотез о виде распределения .

1. Проверим гипотезу о том, что Х распределено по нормальному закону с помощью критерия согласия Пирсона.

где p i - вероятность попадания в i-й интервал случайной величины, распределенной по гипотетическому закону

Для вычисления вероятностей p i применим формулу и таблицу функции Лапласа

где

s = 3.21, x ср = 53.3

Теоретическая (ожидаемая) частота равна n i = np i , где n = 36

| Интервалы группировки | Наблюдаемая частота n i | x 1 = (x i - x ср)/s | x 2 = (x i+1 - x ср)/s | Ф(x 1) | Ф(x 2) | Вероятность попадания в i-й интервал, p i = Ф(x 2) - Ф(x 1) | Ожидаемая частота, 36p i | Слагаемые статистики Пирсона, K i |

| 43 - 45.83 | 1 | -3.16 | -2.29 | -0.5 | -0.49 | 0.01 | 0.36 | 1.14 |

| 45.83 - 48.66 | 1 | -2.29 | -1.42 | -0.49 | -0.42 | 0.0657 | 2.37 | 0.79 |

| 48.66 - 51.49 | 6 | -1.42 | -0.56 | -0.42 | -0.21 | 0.21 | 7.61 | 0.34 |

| 51.49 - 54.32 | 18 | -0.56 | 0.31 | -0.21 | 0.13 | 0.34 | 12.16 | 2.8 |

| 54.32 - 57.15 | 4 | 0.31 | 1.18 | 0.13 | 0.38 | 0.26 | 9.27 | 3 |

| 57.15 - 59.98 | 6 | 1.18 | 2.06 | 0.38 | 0.48 | 0.0973 | 3.5 | 1.78 |

| 36 | 9.84 |

Определим границу критической области. Так как статистика Пирсона измеряет разницу между эмпирическим и теоретическим распределениями, то чем больше ее наблюдаемое значение K набл, тем сильнее довод против основной гипотезы.

Поэтому критическая область для этой статистики всегда правосторонняя: }