ГОСУДАРСТВЕННЫЙ КОМИТЕТ ПО НАУКЕ И ТЕХНИКЕ АЗЕРБАЙДЖАНСКОЙ РЕСПУБЛИКИ

БАКИНСКИЙ НАУЧНО-УЧЕБНЫЙ ЦЕНТР

АСПИРАНТА КАФЕДРЫ ДЕТСКОЙ ХИРУРГИИ

АМУ имени Н. НАРИМАНОВА

МУХТАРОВА ЭМИЛЯ ГАСАН оглы

КОРРЕЛЯЦИОННЫЕ МОМЕНТЫ. КОЭФФИЦИЕНТ КОРРЕЛЯЦИИ

ВВЕДЕНИЕ

Теория вероятности есть математическая наука, изучающая закономерности в случайных явлениях.

Что же понимается под случайными явлениями?

При научном исследовании физических и технических задач, часто приходится встречаться с явлениями особого типа, которые принято называть случайными. Случайное явление - это такое явление, которое при неоднократном воспроизведении одного и того же опыта протекает несколько по-иному.

Приведем пример случайного явления.

Одно и то же тело несколько раз взвешивается на аналитических весах: результаты повторных взвешиваний несколько отличаются друг от друга. Эти различия обусловливаются влиянием различных второстепенных факторов, сопровождающих операцию взвешивания, таких как случайные вибрации аппаратуры, ошибки отсчета показаний прибора и т.д.

Очевидно, что в природе нет ни одного физического явления, в котором не присутствовали бы в той или иной мере элементы случайности. Как бы точно и подробно ни были фиксированы условия опыта, невозможно достигнуть того, чтобы при повторении опыта результаты полностью и в точности совпадали.

Случайности неизбежно сопутствуют любому закономерному явлению. Тем не менее, в ряде практических задач этими случайными элементами можно пренебречь, рассматривая вместо реального явления его упрощенную схему, т.е. модель , и предполагая, что в данных условиях опыта явление протекает вполне определенным образом. При этом из бесчисленного множества факторов, влияющих на данное явление, выделяют самые главные, основные, решающие. Влиянием остальных, второстепенных факторов просто пренебрегают. Изучая закономерности в рамках некоторой теории, основные факторы, влияющие на то или иное явление, входят в понятия или определения, которыми оперирует рассматриваемая теория.

Как и всякая наука, развивающая общую теорию какого-либо круга явлений, теория вероятностей также содержит ряд основных понятий, на которых она базируется. Естественно, что не все основные понятия могут быть строго определены, так как определить понятие - это значит свести его к другим, более известным. Этот процесс должен быть конечным и заканчиваться на первичных понятиях, которые только поясняются.

Одним из первых понятий в теории вероятности вводится понятие события.

Под событием понимается всякий факт, который в результате опыта может произойти или не произойти.

Приведем примеры событий.

А - рождение мальчика или девочки;

В - избрание того или иного дебюта в шахматной игре;

С - принадлежность к тому или иному зодиакальному знаку.

Рассматривая вышеперечисленные события, мы видим, что каждое из них обладает какой-то степенью возможности: одна большей, другие - меньшей. Для того чтобы количественно сравнивать между собой события по степени их возможности, очевидно, нужно с каждым событием связать определенное число, которое тем больше, чем более возможно событие. Такое число называют вероятностью события. Таким образом, вероятность события есть численная характеристика степени объективной возможности события.

За единицу вероятности принимают вероятность достоверного события, равную 1, а диапазон изменения вероятностей любых событий - числа от 0 до 1.

Вероятность обычно обозначают буквой Р.

Рассмотрим на примере извечной проблемы шекспировского Гамлета "быть или не быть?" как можно определить вероятность события.

Вполне очевидно, что человек, предмет и всякое иное явление может находиться в одном из двух и не более состояний: наличия ("быть") и отсутствия ("не быть"). Т.е., возможных событий две, а произойти может только одно. Это означает, что вероятность, например бытия, равна 1/2.

Помимо понятия события и вероятности, одним из основных понятий теории вероятностей является понятие случайной величины.

Случайной величиной называется величина, которая в результате опыта может принять то или иное значение, причем неизвестно заранее какое именно.

Случайные величины, принимающие только отдельные друг от друга значения, которые можно заранее перечислить, называются прерывными или дискретными случайными величинами.

Например:

1. Число выживших и умерших больных.

2. Общее количество детей из поступивших за ночь в больницу больных.

Случайные величины, возможные значения которых непрерывно заполняют некоторый промежуток, называют непрерывными случайными величинами.

Например, ошибка взвешивания на аналитических весах.

Отметим, что современная теория вероятности преимущественно оперирует случайными величинами, а не событиями, на которые в основном опиралась "классическая" теория вероятностей.

КОРРЕЛЯЦИОННЫЕ МОМЕНТЫ. КОЭФФИЦИЕНТ КОРРЕЛЯЦИИ.

Корреляционные моменты, коэффициент корреляции - это числовые характеристики, тесно связанные во введенным выше понятием случайной величины, а точнее с системой случайных величин. Поэтому для введения и определения их значения и роли необходимо пояснить понятие системы случайных величин и некоторые свойства присущие им.

Два или более случайные величины, описывающих некоторое явление называют системой или комплексом случайных величин.

Систему нескольких случайных величин X, Y, Z, …, W принято обозначать через (X, Y, Z, …, W).

Например, точка на плоскости описывается не одной координатой, а двумя, а в пространстве - даже тремя.

Свойства системы нескольких случайных величин не исчерпываются свойствами отдельных случайных величин, входящих в систему, а включают также взаимные связи (зависимости) между случайными величинами. Поэтому при изучении системы случайных величин следует обращать внимание на характер и степень зависимости. Эта зависимость может быть более или менее ярко выраженной, более или менее тесной. А в других случаях случайные величины оказаться практически независимыми.

Случайная величина Y называется независимой от случайной величины Х, если закон распределения случайной величины Y не зависит от того какое значение приняла величина Х.

Следует отметить, что зависимость и независимость случайных величин есть всегда явление взаимное: если Y не зависит от Х, то и величина Х не зависит от Y. Учитывая это, можно привести следующее определение независимости случайных величин.

Случайные величины Х и Y называются независимыми, если закон распределения каждой из них не зависит от того, какое значение приняла другая. В противном случае величины Х и Y называются зависимыми.

Законом распределения случайной величины называется всякое соотношение, устанавливающее связь между возможными значениями случайной величины и соответствующими им вероятностями.

Понятие "зависимости" случайных величин, которым пользуются в теории вероятностей, несколько отличается от обычного понятия "зависимости" величин, которым пользуются в математике. Так, математик под "зависимостью" подразумевает только один тип зависимости - полную, жесткую, так называемую функциональную зависимость. Две величины Х и Y называются функционально зависимыми, если, зная значение одного из них, можно точно определить значение другой.

В теории вероятностей встречаются несколько с иным типом зависимости - вероятностной зависимостью . Если величина Y связана с величиной Х вероятностной зависимостью, то, зная значение Х, нельзя точно указать значение Y, а можно указать её закон распределения, зависящий от того, какое значение приняла величина Х.

Вероятностная зависимость может быть более или менее тесной; по мере увеличения тесноты вероятностной зависимости она все более приближается к функциональной. Т.о., функциональную зависимость можно рассматривать как крайний, предельный случай наиболее тесной вероятностной зависимости. Другой крайний случай - полная независимость случайных величин. Между этими двумя крайними случаями лежат все градации вероятностной зависимости - от самой сильной до самой слабой.

Вероятностная зависимость между случайными величинами часто встречается на практике. Если случайные величины Х и Y находятся в вероятностной зависимости, то это не означает, что с изменением величины Х величина Y изменяется вполне определенным образом; это лишь означает, что с изменением величины Х величина Y

имеет тенденцию также изменяться (возрастать или убывать при возрастании Х). Эта тенденция соблюдается лишь в общих чертах, а в каждом отдельном случае возможны отступления от неё.

Примеры вероятностной зависимости.

Выберем наугад одного больного с перитонитом. случайная величина Т - время от начала заболевания, случайная величина О - уровень гомеостатических нарушений. Между этими величинами имеется явная зависимость, так как величина Т является одной из наиболее главных причин, определяющих величину О.

В то же время между случайной величиной Т и случайной величиной М, отражающей летальность при данной патологии, имеется более слабая вероятностная зависимость, так как случайная величина хоть и влияет на случайную величину О, однако не является главной определяющей.

Тем более, если рассматривать величину Т и величину В (возраст хирурга), то данные величины практически независимы.

До сих пор мы обсуждали свойства систем случайных величин, давая только словесное разъяснение. Однако существуют числовые характеристики, посредством которых исследуются свойства как отдельных случайных величин, так и системы случайных величин.

- Коэффициент корреляции Спирмена: пример решения задачи

Случайная величина описывается двумя числовыми характеристиками: математическим ожиданием и дисперсией. Чтобы описать систему из двух случайных величин кроме «основных» характеристик используют так же корреляционный момент и коэффициент корреляции.

Корреляционным моментом

µ xy

случайных величин X и У называют математическое ожидание произведения отклонений этих величин:

µ xy = M { [ X - M(X) ] [ Y - M(Y) ] }

Для нахождения корреляционного момента дискретных величин используют формулу:

а для непрерывных величин - формулу:

Корреляционный момент характеризует наличие (отсутствие) связи между величинами X и У. Ниже будет доказано, что корреляционный момент равен нулю, если X и У независимы; Если же корреляционный момент для случайных величин X и Y не равен нулю, то между ними имеется завимость.

Замечание 1. Приняв во внимание, что отклонения есть центрированные случайные величины, можно дать корреляционному моменту определение, как математическому ожиданию произведения двух центрированных случайных величин:

µ xy = М .

Замечание 2. Не сложно доказать, что корреляционный момент можно записать в виде

µ xy = М (ХY) – М(X) М(У).

Теорема 1. Корреляционный момент двух независимых случайных величин X и Y равен нулю.

Доказательство. Так как X и У- независимые случайные величины, то их отклонения X-М (X) и У-М (У) также независимы. Пользуясь свойствами математического ожидания (математическое ожидание произведения независимых случайных величин равно произведению математических ожиданий сомножителей) и отклонения (математическое ожидание отклонения равно нулю), получим

µ xy = М { M} = М M = 0.

Из определения корреляционного момента следует, что он имеет размерность, равную произведению размерностей величин X и У. Другими словами, величина корреляционного момента зависит от единиц измерения случайных величин. По этой причине для одних и тех же двух величин величина корреляционного момента имеет различные значения в зависимости от того, в каких еди- ницах были измерены величины. Пусть, например, X и У были измерены в сантиметрах и µxy = 2 см2; если измерить X и У в миллиметрах,

то µxy = 200 мм. Такая особенность корреляционного мо-мента является недостатком этой числовой характеристики, поскольку сравнение корреляционных моментов различных систем случайных величин становится затруднительным. Для того чтобы устранить этот недостаток, вводят новую числовую характеристику-коэффициент корреляции

.

Коэффициентом корреляции

г ху случайных величин X и У называют отношение корреляционного момента к произведению средних квадратических отклонений этих

величин:

r xy = µ xy /σ x σ y

Так как размерность µxy равна произведению размерностей величин X и У, σ x имеет размерность величины X, σ y имеет размерность величины Y, то r xy -безразмерная величина. Таким образом, величина коэффициента корреляции не зависит от выбора единиц измерения случайных величин. В этом состоит преимущество коэффициента корреляции перед корреляционным моментом.

Очевидно, коэффициент корреляции независимых случайных величин равен нулю (так как µ xy = 0).

Замечание 3 . Во многих вопросах теории вероятностей целесообразно вместо случайной величины X рассматривать нормированную случайную величину X", которую определяют как отношение отклонения к среднему квадратическому отклонению:

Х" = (Х - М(Х))/σ x .

Нормированная величина имеет математическое ожидание, равное нулю, и дисперсию, равную единице. Действительно, используя свойства математического ожидания и дисперсии, имеем:

Легко убедиться, что коэффициент корреляции r ху равен корреляционному моменту нормированных величин Х" и Y" :

Теорема 2. Абсолютная величина корреляционного момента двух случайных величин X и Y не превышает среднего геометрического их дисперсий:

Доказательство. Введем в рассмотрение случайную величину Z 1 = σ y X - σ x Y и найдем ее дисперсию D(Z l) = M 2 . Выполнив выкладки, получим

D(Z 1) = 2σ x 2 σ y 2 – 2σ x σ y µ xy

Любая дисперсия неотрицательна, поэтому

2σ x 2 σ y 2 – 2σ x σ y µ xy ≥0.

µ xy ≤ σ x σ y .

Введя случайную величину Z t = σ y X+ σ x Y, аналогично найдем

µ xy ≥ − σ x σ y .

Объединим два этих неравенства:

σ x σ y ≤ µ xy ≤ σ x σ y или | µ xy | ≤ σ x σ y

Теорема 3. Абсолютная величина коэффициента корреляции не превышает единицы:

Доказательство: Разделим обе части полученного двойного неравенства на произведение положительных чисел σxσy:

1 ≤ r xy ≤ 1

Как часто Вам приходилось слышать высказывания, в которых говорилось о том, что одно явление коррелируется с другим?

«Высокий рост коррелируется с хорошим образованием и счастьем, установили эксперты социологической службы Gallup.»

«Цена на нефть коррелируется с курсами валют.»

«Боль в мышцах после тренировки не коррелируется с гипертрофией мышечных волокон.»

Складывается впечатление, что понятие «корреляция» стало широко использоваться не только в науке, но и в повседневной жизни. Корреляция отражает степень линейной зависимости между двумя случайными явлениями. Так, когда цены на нефть начинают падать, то курс доллара относительно рубля начинает расти.

Из всего выше сказанного, можно сделать вывод о том, что при описании двумерных случайных величин бывает недостаточно таких хорошо известных характеристик, как математическое ожидание, дисперсия, среднее квадратическое отклонение. Поэтому часто для их описания используются еще две очень важные характеристики: ковариация и корреляция .

Ковариация

Ковариацией $cov\left(X,\ Y\right)$ случайных величин $X$ и $Y$ называется математическое ожидание произведения случайных величин $X-M\left(X\right)$ и $Y-M\left(Y\right)$, то есть:

$$cov\left(X,\ Y\right)=M\left(\left(X-M\left(X\right)\right)\left(Y-M\left(Y\right)\right)\right).$$

Бывает удобно вычислять ковариацию случайных величин $X$ и $Y$ по следующей формуле:

$$cov\left(X,\ Y\right)=M\left(XY\right)-M\left(X\right)M\left(Y\right),$$

которая может быть получена из первой формулы, используя свойства математического ожидания. Перечислим основные свойства ковариации .

1 . Ковариация случайной величины с самой собой есть ее дисперсия.

$$cov\left(X,\ X\right)=D\left(X\right).$$

2 . Ковариация симметрична.

$$cov\left(X,\ Y\right)=cov\left(Y,\ X\right).$$

3 . Если случайные величины $X$ и $Y$ независимы, то:

$$cov\left(X,\ Y\right)=0.$$

4 . Постоянный множитель можно выносить за знак ковариации.

$$cov\left(cX,\ Y\right)=cov\left(X,\ cY\right)=c\cdot cov\left(X,\ Y\right).$$

5 . Ковариация не изменится, если к одной из случайных величин (или двум сразу) прибавить постоянную величину:

$$cov\left(X+c,\ Y\right)=cov\left(X,\ Y+c\right)=cov\left(X+x,\ Y+c\right)=cov\left(X,\ Y\right).$$

6 . $cov\left(aX+b,\ cY+d\right)=ac\cdot cov\left(X,\ Y\right)$.

7 . $\left|cov\left(X,\ Y\right)\right|\le \sqrt{D\left(X\right)D\left(Y\right)}$.

8 . $\left|cov\left(X,\ Y\right)\right|=\sqrt{D\left(X\right)D\left(Y\right)}\Leftrightarrow Y=aX+b$.

9 . Дисперсия суммы (разности) случайных величин равна сумме их дисперсий плюс (минус) удвоенная ковариация этих случайных величин:

$$D\left(X\pm Y\right)=D\left(X\right)+D\left(Y\right)\pm 2cov\left(X,\ Y\right).$$

Пример 1 . Дана корреляционная таблица случайного вектора $\left(X,\ Y\right)$. Вычислить ковариацию $cov\left(X,\ Y\right)$.

$\begin{array}{|c|c|}

\hline

\hline

-2 & 0,1 & 0 & 0,2 \\

\hline

0 & 0,05 & p_{22} & 0 \\

\hline

1 & 0 & 0,2 & 0,05 \\

\hline

7 & 0,1 & 0 & 0,1 \\

\hline

\end{array}$

События $\left(X=x_i,\ Y=y_j\right)$ образуют полную группу событий, поэтому сумма всех вероятностей $p_{ij}$, указанных в таблице, должна быть равна 1. Тогда $0,1+0+0,2+0,05+p_{22}+0+0+0,2+0,05+0,1+0+0,1=1$, отсюда $p_{22}=0,2$.

$\begin{array}{|c|c|}

\hline

X\backslash Y & -6 & 0 & 3 \\

\hline

-2 & 0,1 & 0 & 0,2 \\

\hline

0 & 0,05 & 0,2 & 0 \\

\hline

1 & 0 & 0,2 & 0,05 \\

\hline

7 & 0,1 & 0 & 0,1 \\

\hline

\end{array}$

Пользуясь формулой $p_{i} =\sum _{j}p_{ij} $, находим ряд распределения случайной величины $X$.

$\begin{array}{|c|c|}

\hline

X & -2 & 0 & 1 & 7 \\

\hline

p_i & 0,3 & 0,25 & 0,25 & 0,2 \\

\hline

\end{array}$

$$M\left(X\right)=\sum^n_{i=1}{x_ip_i}=-2\cdot 0,3+0\cdot 0,25+1\cdot 0,25+7\cdot 0,2=1,05.$$

$$D\left(X\right)=\sum^n_{i=1}{p_i{\left(x_i-M\left(X\right)\right)}^2}=0,3\cdot {\left(-2-1,05\right)}^2+0,25\cdot {\left(0-1,05\right)}^2+0,25\cdot {\left(1-1,05\right)}^2+$$

$$+\ 0,2\cdot {\left(7-1,05\right)}^2=10,1475.$$

$$\sigma \left(X\right)=\sqrt{D\left(X\right)}=\sqrt{10,1475}\approx 3,186.$$

Пользуясь формулой $q_{j} =\sum _{i}p_{ij} $, находим ряд распределения случайной величины $Y$.

$\begin{array}{|c|c|}

\hline

Y & -6 & 0 & 3 \\

\hline

p_i & 0,25 & 0,4 & 0,35 \\

\hline

\end{array}$

$$M\left(Y\right)=\sum^n_{i=1}{y_ip_i}=-6\cdot 0,25+0\cdot 0,4+3\cdot 0,35=-0,45.$$

$$D\left(Y\right)=\sum^n_{i=1}{p_i{\left(y_i-M\left(Y\right)\right)}^2}=0,25\cdot {\left(-6+0,45\right)}^2+0,4\cdot {\left(0+0,45\right)}^2+0,35\cdot {\left(3+0,45\right)}^2=11,9475.$$

$$\sigma \left(Y\right)=\sqrt{D\left(Y\right)}=\sqrt{11,9475}\approx 3,457.$$

Поскольку $P\left(X=-2,\ Y=-6\right)=0,1\ne 0,3\cdot 0,25$, то случайные величины $X,\ Y$ являются зависимыми.

Определим ковариацию $cov\ \left(X,\ Y\right)$ случайных величин $X,\ Y$ по формуле $cov\left(X,\ Y\right)=M\left(XY\right)-M\left(X\right)M\left(Y\right)$. Математическое ожидание произведения случайных величин $X,\ Y$ равно:

$$M\left(XY\right)=\sum_{i,\ j}{p_{ij}x_iy_j}=0,1\cdot \left(-2\right)\cdot \left(-6\right)+0,2\cdot \left(-2\right)\cdot 3+0,05\cdot 1\cdot 3+0,1\cdot 7\cdot \left(-6\right)+0,1\cdot 7\cdot 3=-1,95.$$

Тогда $cov\left(X,\ Y\right)=M\left(XY\right)-M\left(X\right)M\left(Y\right)=-1,95-1,05\cdot \left(-0,45\right)=-1,4775.$ Если случайные величины независимы, то их ковариации равна нулю. В нашем случае $cov(X,Y)\ne 0$.

Корреляция

Коэффициентом корреляции случайных величин $X$ и $Y$ называется число:

$$\rho \left(X,\ Y\right)={{cov\left(X,\ Y\right)}\over {\sqrt{D\left(X\right)D\left(Y\right)}}}.$$

Перечислим основные свойства коэффициента корреляции .

1 . $\rho \left(X,\ X\right)=1$.

2 . $\rho \left(X,\ Y\right)=\rho \left(Y,\ X\right)$.

3 . $\rho \left(X,\ Y\right)=0$ для независимых случайных величин $X$ и $Y$.

4 . $\rho \left(aX+b,\ cY+d\right)={sgn \left(ac\right)\rho \left(X,\ Y\right)\ }$, где ${sgn \left(ac\right)\ }$ - знак произведения $ac$.

5 . $\left|\rho \left(X,\ Y\right)\right|\le 1$.

6 . $\left|\rho \left(X,\ Y\right)\right|=1\Leftrightarrow Y=aX+b$.

Ранее было сказано, что коэффициент корреляции $\rho \left(X,\ Y\right)$ отражает степень линейной зависимости между двумя случайными величинами $X$ и $Y$.

При $\rho \left(X,\ Y\right)>0$ можно сделать вывод о том, что с ростом случайной величины $X$ случайная величина $Y$ имеет тенденцию к увеличению. Это называется положительной корреляционной зависимостью. Например, рост и вес человека связаны положительной корреляционной зависимостью.

При $\rho \left(X,\ Y\right)<0$ можно сделать вывод о том, что с ростом случайной величины $X$ случайная величина $Y$ имеет тенденцию к уменьшению. Это называется отрицательной корреляционной зависимостью. Например, температура и время сохранности продуктов питания связаны между собой отрицательной корреляционной зависимостью.

При $\rho \left(X,\ Y\right)=0$ случайные величины $X$ и $Y$ называются некоррелированными. Стоит отметить, что некоррелированность случайных величин $X$ и $Y$ не означает их статистическую независимость, это говорит лишь о том, что между ними нет линейной зависимости.

Пример 2 . Определим коэффициент корреляции $\rho \left(X,\ Y\right)$ для двумерной случайной величины $\left(X,\ Y\right)$ из примера 1.

Коэффициент корреляции случайных величин $X,\ Y$ равен $r_{XY} ={cov(X,Y)\over \sigma (X)\sigma (Y)} ={-1,4775\over 3,186\cdot 3,457} =-0,134.$ Поскольку $r_{XY}<0$, то с ростом $X$ случайная величина $Y$ имеет тенденцию к уменьшению (отрицательная корреляционная зависимость).

Для описания системы двух случайных величин, кроме математических ожиданий и дисперсий составляющих пользуются и другими характеристиками, к числу которых относятся корреляционный момент икоэффициент корреляции (кратко было упомянуто в конце Т.8.п.8.6).

Корреляционным моментом (иликовариацией, или моментом связи ) двух случайных величинX иY называется м. о. произведения отклонений этих величин (см. равенство (5) п. 8.6):

Следствие 1. Длякорреляционного момента с.в. X иY также справедливы равенства:

,

,

где соответствующие централизованные с.в.X иY (см. п.8.6.).

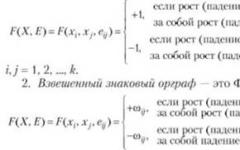

При

этом: если

-

двумерная д.с.в., то ковариация вычисляется

по формуле

-

двумерная д.с.в., то ковариация вычисляется

по формуле

(8)

;

;

если

-

двумерная н.с.в., то ковариация вычисляется

по формуле

-

двумерная н.с.в., то ковариация вычисляется

по формуле

(9)

Формулы (8) и (9) получены на основании формул (6) п.12.1. Имеет место вычислительная формула

(10)

которая выводится из определения (9) и на основании свойств м.о., действительно,

Следовательно, формул (36) и (37) можно переписать в виде

(11)

;

;

Корреляционный момент служит для характеристики связи между величинами X иY .

Как будет показано ниже, корреляционный момент равен нулю, если X иY являются независимыми;

Следовательно, если корреляционный момент не равен нулю, то X и Y – зависимые случайные величины.

Теорема12.1.

Корреляционный момент

двух независимых случайных величин

X

и

Y

равен нулю,

т.е. для независимых с.в.

X

и

Y

,

Доказательство. Так какX иY независимые случайные величины, то их отклонения

и

и

т

акже

независимы. Пользуясь свойствами

математического ожидания (математическое

ожидание произведения независимых с.

в. равно произведению математических

ожиданий сомножителей ,

, ,

поэтому

,

поэтому

Замечание.

Из этой теоремы следует,

что если

то с.в.

X

иY

зависимы и в таких случаях с.в.

X

иY

называюткоррелированными

. Однако из того,

что

то с.в.

X

иY

зависимы и в таких случаях с.в.

X

иY

называюткоррелированными

. Однако из того,

что

не следует независимость с.в.X

иY

.

не следует независимость с.в.X

иY

.

В этом случае ( с.в.X

иY

называютнекоррелированными,

тем

самым из

с.в.X

иY

называютнекоррелированными,

тем

самым из

независимости вытекает некоррелированность ; обратное утверждение, вообще говоря, неверно (см. далее пример 2.)

Рассмотрим основные свойства корреляционного момента.

C войства ковариации:

1.

Ковариация симметрична, т.е.

.

.

Непосредственно следует из формулы (38).

2. Имеют место равенства:т.е. дисперсия с.в. является ковариацией её с самой собой.

Эти равенства прямо следуют из определения

дисперсии и равенство (38) соотвеиственно

при

3. Справедливы равенства:

Эти

равенства выводятся из определения

дисперсии, ковариации с.в. и

и ,

свойств 2.

,

свойств 2.

По определению дисперсии (с учётом

централизованности с.в.

)

мы имеем

)

мы имеем

теперь, на основании (33) и свойств 2 и 3, получим первое (со знаком плюс) свойство 3.

Аналогично, вторая часть свойства3, выводится из равенство

4.

Пусть постоянные

числа,

постоянные

числа, тогда справедливы равенства:

тогда справедливы равенства:

Обычно эти свойства называются свойствами однородностью первого порядка и периодичностью по аргументам.

Докажем

первое равенство, при этом будем

использовать свойства м.о.

.

.

Теорема 12.2. Абсолютное значение корреляционного момента двух произвольных случайных величин X и Y не превышает среднего геометрического их дисперсий: т.е.

Доказательство.

Заметим, чтодля

независимых с.в. неравенство выполняется

(с.м. теорему 12.1.). Итак, пусть с.в.X

и

Y

зависимые.

Рассмотрим стандартные с.в. и

и и вычислим дисперсию с.в.

и вычислим дисперсию с.в. с учётом свойства 3, имеем: с одной

стороны

с учётом свойства 3, имеем: с одной

стороны С другой стороны

С другой стороны

Следовательно,

с учётом того, что

и

и -

нормированные (стандартизированные)

с.в., то для них м.о. равна нулю, а дисперсия

равна 1, поэтому, пользуясь свойством

м.о.

-

нормированные (стандартизированные)

с.в., то для них м.о. равна нулю, а дисперсия

равна 1, поэтому, пользуясь свойством

м.о. получим

получим

а

следовательно, на основании того, что

получим

получим

Отсюда следует, что т.е.

=

=

Утверждение доказано.

Из определения и свойства ковариации

следует, что она характеризует и степень

зависимости с.в., и их рассеяния вокруг

точки

Размерность ковариации равна произведению

размерностей случайных величинX

иY

. Другими словами,

величина корреляционного момента

зависит от единиц измерения случайных

величин. По этой причине для одних и тех

же двух величинX

иY

,

величина корреляционного момента

будет иметь различные значения в

зависимости от того, в каких единицах

были измерены величины.

Размерность ковариации равна произведению

размерностей случайных величинX

иY

. Другими словами,

величина корреляционного момента

зависит от единиц измерения случайных

величин. По этой причине для одних и тех

же двух величинX

иY

,

величина корреляционного момента

будет иметь различные значения в

зависимости от того, в каких единицах

были измерены величины.

Пусть, например, X

и Y

были измерены в

сантиметрах и

;

если измерить X

иY

в миллиметрах,

то

;

если измерить X

иY

в миллиметрах,

то Эта особенность корреляционного момента

и есть недостатком этой числовой

характеристики, так как сравнение

корреляционных моментов различных

систем случайных величин становится

затруднительным.

Эта особенность корреляционного момента

и есть недостатком этой числовой

характеристики, так как сравнение

корреляционных моментов различных

систем случайных величин становится

затруднительным.

Для того чтобы устранить этот недостаток, вводят новую числовую характеристику- - «коэффициент корреляции ».

Коэффициентом корреляции

случайных величин

случайных величин

и

и называют отношение корреляционного

момента к произведению средних

квадратических отклонений этих величин:

называют отношение корреляционного

момента к произведению средних

квадратических отклонений этих величин:

(13)

.

.

Так как размерность

равна произведению размерностей величин

равна произведению размерностей величин

и

и ,

, имеет размерность величины

имеет размерность величины σ y

имеет размерность величины

σ y

имеет размерность величины ,

то

,

то

есть просто число (т.е. «безразмерная

величина»

). Таким образом, величина

коэффициента корреляции не зависит от

выбора единиц измерения с.в., в этом

состоитпреимущество

коэффициента

корреляции перед корреляционным

моментом.

есть просто число (т.е. «безразмерная

величина»

). Таким образом, величина

коэффициента корреляции не зависит от

выбора единиц измерения с.в., в этом

состоитпреимущество

коэффициента

корреляции перед корреляционным

моментом.

В Т.8. п.8.3 нами было введено понятие

нормированной

с.в. ,

формула (18), и доказана теорема о том,

что

,

формула (18), и доказана теорема о том,

что и

и (см.

там же теорема 8.2.). Здесь докажем следующее

утверждение.

(см.

там же теорема 8.2.). Здесь докажем следующее

утверждение.

Теорема 12.3.

Длялюбых двух случайных

величин

и

и

справедливо

равенство

справедливо

равенство

.Другими словами, коэффициент корреляции

.Другими словами, коэффициент корреляции

любых двух с

.в

.X

и

Y

равно

корреляционному моменту их соответствующих

нормированных

с.в.

любых двух с

.в

.X

и

Y

равно

корреляционному моменту их соответствующих

нормированных

с.в. и

и

.

.

Доказательство.

По определениюнормированных случайных величин и

и

и

и .

.

Учитывая свойство математического ожидания: и равенство (40) получим

Утверждение доказано.

Рассмотрим некоторые часто встречающие свойства коэффициента корреляции.

Свойства коэффициента корреляции:

1. Коэффициент корреляции по абсолютной величине непревосходит 1, т.е.

Это свойство прямо следует из формулы (41) - определения коффициента корреляции и теоремы 13.5. (см. равенство (40)).

2. Если случайные величины и

и независимы,

токоэффициент корреляции

равен нулю, т.е.

независимы,

токоэффициент корреляции

равен нулю, т.е.

.

.

Это свойство является прямым следствием равенства (40) и теоремы 13.4.

Следующее свойство сформулируем в виде отдельной теоремы.

Теорема 12.4.

Если

с.в.

и

и между

собой связаны линейной функциональной

зависимостью, т.е.

между

собой связаны линейной функциональной

зависимостью, т.е. то

то

при этом

при этом

и

наоборот, если

,

то

с.в.

,

то

с.в.

и

и

между собой связаны линейной функциональной

зависимостью, т.е. существуют постоянные

между собой связаны линейной функциональной

зависимостью, т.е. существуют постоянные и

и

такие, что имеет место равенство

такие, что имеет место равенство

Доказательство.

Пусть

тогда

на основании

свойства 4 ковариации, имеем

тогда

на основании

свойства 4 ковариации, имеем

и поскольку, , поэтому

Следовательно,

.

Равенство в одну сторону получено. Пусть

далее,

.

Равенство в одну сторону получено. Пусть

далее, ,

тогда

,

тогда

следует

рассматривать два случая:1)

и

2)

и

2) Итак, рассмотрим первый случай. Тогда

по определению

Итак, рассмотрим первый случай. Тогда

по определению и

следовательно из равенства

и

следовательно из равенства ,

где

,

где .

В нашем случае

.

В нашем случае ,

поэтому из равенства (см. доказательство

теоремы 13.5.)

,

поэтому из равенства (см. доказательство

теоремы 13.5.)

=

= ,

,

получаем,

что

,

значит

,

значит постоянна.

Так как

постоянна.

Так как и поскольку,

то

и поскольку,

то действительно,

действительно,

.

.

Следовательно,

.

.

Аналогично,

показывается, что для

имеет место (проверьте самостоятельно!)

имеет место (проверьте самостоятельно!)

,

, .

.

Некоторые выводы:

1. Если

и

и независимыес.в., то

независимыес.в., то

2. Если с.в. и

и между

собой связаны линейно, то

между

собой связаны линейно, то .

.

3. В остальных случаях

:

:

В этом

случае говорят, что с.в. и

и связаны между собойположительной

корреляцией,

если

связаны между собойположительной

корреляцией,

если в случаях же

в случаях же отрицательной

корреляцией

. Чем ближе

отрицательной

корреляцией

. Чем ближе к единице, тем больше оснований считать,

чтос.в.

к единице, тем больше оснований считать,

чтос.в. и

и связаны линейной зависимостью.

связаны линейной зависимостью.

Отметим, что корреляционные моменты и дисперсии системы с.в. обычно задаются корреляционной матрицей :

.

.

Очевидно, что определитель корреляционной матрицы удовлетворяет:

Как уже было отмечено, если две случайные величины зависимы, то они могут быть как коррелированными , так инекоррелированными. Другими словами, корреляционный момент двух зависимых величин может бытьне равен нулю , но может иравняться нулю.

Пример 1. Закон распределения дискретной с.в.задан таблицей

|

| |||

|

|

|

|

|

|

|

|

|

Найти

коэффициент корреляции

Решение.

Находим законы распределения

составляющих и

и :

:

Теперь вычислим м.о. составляющих:

Этих

величин можно было находить на основании

таблицы распределения с.в.

Аналогично,

находите

самостоятельно.

находите

самостоятельно.

Вычислим дисперсии составляющих при это будем пользоваться вычислительной формулой:

Составим

закон распределения

,

а затем найдём

,

а затем найдём :

:

При составлении таблицы закона распределения следует выполнять действия:

1) оставить лишь различные значения

всевозможных произведений

.

.

2) для определения вероятности данного

значения

,

нужно

,

нужно

складывать все соответствующие вероятности, находящиеся на пересечении основной таблицы, благоприятствующие наступлению данного значения.

В нашем примере с.в. принимает

всего три различных значения

принимает

всего три различных значения .

Здесь первое значение (

.

Здесь первое значение ( )

соответствует произведению

)

соответствует произведению из второй строки и

из второй строки и из первого столбца, поэтому на их

пересечении находится вероятностное

число

из первого столбца, поэтому на их

пересечении находится вероятностное

число аналогично

аналогично

которое

получено из суммы вероятностей,

находящихся на пересечениях соответственно

первой строки и первого столбца (0,15 ;

0,40; 0,05) и одно значение

,

которое находится на пересечении второй

строки и второго столбца, и наконец,

,

которое находится на пересечении второй

строки и второго столбца, и наконец, ,

которое находится на пересечении второй

строки и третьего столбца.

,

которое находится на пересечении второй

строки и третьего столбца.

Из нашей таблицы находим:

Находим корреляционный момент, используя формулу (38):

Находим коэффициент корреляции по формуле (41)

Таким образом, отрицательная корреляция.

Упражнение. Закон распределения дискретной с.в. задан таблицей

|

| |||

|

|

|

|

|

|

|

|

|

Найти коэффициент корреляции

Рассмотрим пример, где окажется две зависимые случайные величины могут бытьнекоррелированными.

Пример 2.

Двумерная случайная величина

)

задана функцией плотностью

)

задана функцией плотностью

Докажем, что

и

и зависимые

,

нонекоррелированные

случайные величины.

зависимые

,

нонекоррелированные

случайные величины.

Решение.

Воспользуемся ранее

вычисленными плотностями распределения

составляющих и

и

:

:

Так

как

,то  и

и зависимые

величины. Для того, чтобы доказать

некоррелированность

зависимые

величины. Для того, чтобы доказать

некоррелированность

и

и ,

достаточно убедиться в том, что

,

достаточно убедиться в том, что

Найдем корреляционный момент по формуле:

Поскольку дифференциальная функция

симметрична относительно

оси OY

,

то

симметрична относительно

оси OY

,

то

аналогично

аналогично ,

в силу симметрии

,

в силу симметрии относительно оси OX

.

Поэтому,

относительно оси OX

.

Поэтому,

вынося

постоянный множитель

Внутренний интеграл равен

нулю (подынтегральная функция нечетна,

пределы интегрирования симметричны

относительно начала координат),

следовательно,

,

т.е. зависимые случайные величины

,

т.е. зависимые случайные величины и

и между собой некоррелируют.

между собой некоррелируют.

Итак, из коррелированности двух случайных величин следует их зависимость, но из некоррелированности ещё нельзя заключить о независимости этих величин.

Однако, для нормально распределённых с.в. такой вывод является исключением, т.е. из некоррелированности нормально распределенных с.в. вытекает их независимость .

Этому вопросу посвящается следующий пункт.