Находит широкое применение в эконометрике в виде четкой экономической интерпретации ее параметров.

Линейная регрессия сводится к нахождению уравнения вида

или

Уравнение вида  позволяет по заданным значениям параметра х

иметь теоретические значения результативного признака, подставляя в него фактические значения фактора х

.

позволяет по заданным значениям параметра х

иметь теоретические значения результативного признака, подставляя в него фактические значения фактора х

.

Построение линейной регрессии сводится к оценке ее параметров — а и в. Оценки параметров линейной регрессии могут быть найдены разными методами.

Классический подход к оцениванию параметров линейной регрессии основан на методе наименьших квадратов (МНК).

МНК позволяет получить такие оценки параметров а и в, при которых сумма квадратов отклонений фактических значений ре-зультативного признака (у) от расчетных (теоретических) ми-нимальна:

Чтобы найти минимум функции, надо вычислить част-ные производные по каждому из параметров а и b и приравнять их к нулю.

Обозначим  через S, тогда:

через S, тогда:

Преобразуя формулу, получим следующую систему нормальных уравнений для оценки параметров а и в :

Решая систему нормальных уравнений (3.5) либо методом последовательного исключения переменных, либо методом определителей, найдем искомые оценки параметров а и в.

Параметр в называется коэффициентом регрессии. Его величина показывает среднее изменение результата с изменением фактора на одну единицу.

Уравнение регрессии всегда дополняется показателем тесноты связи. При использовании линейной регрессии в качестве такого показателя выступает линейный коэффициент корреляции . Существуют разные модификации формулы линейного коэффициента корреляции. Некоторые из них приведены ниже:

Как известно, линейный коэффициент корреляции находится в границах: -1 ≤ ≤ 1.

Для оценки качества подбора линейной функции рассчитывается квадрат

Линейного коэффициента корреляции называемый коэффициентом детерминации . Коэффициент детерминации характеризует долю дисперсии результативного признака у, объясняемую регрессией, в общей дисперсии результативного признака:

Соответственно величина 1 - характеризует долю диспер-сии у, вызванную влиянием остальных не учтенных в модели факторов.

Вопросы для самоконтроля

1. Суть метода наименьших квадратов?

2. Сколькими переменными предоставляется парная регрессия?

3. Каким коэффициентом определяется теснота связи между переменами?

4. В каких пределах определяется коэффициент детерминации?

5. Оценка параметра b в корреляционно-регрессионном анализе?

1. Кристофер Доугерти. Введение в эконометрию. - М.: ИНФРА - М, 2001 - 402 с.

2. С.А. Бородич. Эконометрика. Минск ООО «Новое знание» 2001.

3. Р.У. Рахметова Краткий курс по эконометрике. Учебное пособие. Алматы. 2004. -78с.

4. И.И. Елисеева.Эконометрика. - М.: «Финансы и статистика»,2002

5. Ежемесячный информационно-аналитический журнал.

Нелинейные экономические модели. Нелинейные модели регрессии. Преобразование переменных.

Нелинейные экономические модели..

Преобразование переменных.

Коэффициент эластичности.

Если между экономическими явлениями существуют нели-нейные соотношения, то они выражаются с помощью соответ-ствующих нелинейных функций: например, равносторонней ги-перболы  ,

параболы второй степени

,

параболы второй степени  и д.р.

и д.р.

Различают два класса нелинейных регрессий:

1. Регрессии, нелинейные относительно включенных в анализ объясняющих переменных, но линейные по оцениваемым параметрам, например:

Полиномы различных степеней - ![]() , ;

, ;

Равносторонняя гипербола - ;

Полулогарифмическая функция - .

2. Регрессии, нелинейные по оцениваемым параметрам, например:

Степенная - ;

Показательная - ;

Экспоненциальная - .

Общая сумма квадратов отклонений индивидуальных значений результативного признака у от среднего значения вызвана влиянием множества причин. Условно разделим всю совокупность причин на две группы: изучаемый фактор х и прочие факторы.

Если фактор не оказывает влияния на результат, то линия регрес-сии на графике параллельна оси ох

и

Тогда вся дисперсия результативного признака обусловлена воздействием прочих факторов и общая сумма квадратов отклонений совпадет с остаточной. Если же прочие факторы не влияют на результат, то у связан с х функционально и остаточная сумма квадратов равна нулю. В этом случае сумма квадратов отклонений, объясненная регрессией, совпадает с общей суммой квадратов.

Поскольку не все точки поля корреляции лежат на линии регрессии, то всегда имеет место их разброс как обусловленный вли-янием фактора х , т. е. регрессией у по х, так и вызванный действием прочих причин (необъясненная вариация). Пригод-ность линии регрессии для прогноза зависит от того, какая часть общей вариации признака у приходится на объясненную вариа-цию

Очевидно, что если сумма квадратов отклонений, обусловленная регрессией, будет больше остаточной суммы квадратов, то уравнение регрессии статистически значимо и фактор х оказывает существенное воздействие на результат у.

, т. е. с числом свободы независимого варьирования признака. Число степеней свободы связано с числом единиц совокупности n и с числом определяемых по ней констант. Применительно к исследуемой проблеме число степеней свободы должно показать, сколько независимых откло-нений из п

Оценка значимости уравнения регрессии в целом дается с по-мощью F -критерия Фишера. При этом выдвигается нулевая ги-потеза, что коэффициент регрессии равен нулю, т. е. b = 0, и следовательно, фактор х не оказывает влияния на результат у.

Непосредственному расчету F-критерия предшествует анализ дисперсии. Центральное место в нем занимает разложе-ние общей суммы квадратов отклонений переменной у от средне го значения у на две части - «объясненную» и «необъясненную»:

- общая сумма квадратов отклонений;

- общая сумма квадратов отклонений;

- сумма квадратов отклонения объясненная регрессией;

- сумма квадратов отклонения объясненная регрессией;

- остаточная сумма квадратов отклонения.

- остаточная сумма квадратов отклонения.

Любая сумма квадратов отклонений связана с числом степе-ней свободы, т. е. с числом свободы независимого варьирования признака. Число степеней свободы связано с числом единиц совокупности n и с числом определяемых по ней констант. Применительно к исследуемой проблеме число cтепеней свободы должно показать, сколько независимых откло-нений из п возможных требуется для образования данной суммы квадратов.

Дисперсия на одну степень свободы D .

F-отношения (F-критерий):

Ecли нулевая гипотеза справедлива , то факторная и остаточная дисперсии не отличаются друг от друга. Для Н 0 необходимо опровержение,чтобы факторная дисперсия превышала остаточную в несколько раз. Английским статистиком Снедекором раз-работаны таблицы критических значений F -отношений при разных уровняхсущественности нулевой гипотезы и различном числе степенейсвободы. Табличное значение F -критерия — это максимальная величина отношения дисперсий, которая может иметь место прислучайном их расхождении для данного уровня вероятности наличия нулевой гипотезы. Вычисленное значение F -отношения признается достоверным, если о больше табличного.

В этом случае нулевая гипотеза об отсутствии связи признаков отклоняется и делается вывод о существенности этой связи: F факт > F табл Н 0 отклоняется.

Если же величина окажется меньше табличной F факт ‹, F табл , то вероятность нулевой гипотезы выше заданного уровня и она не может быть отклонена без серьезного риска сделать неправильный вывод о наличии связи. В этом случае уравнение регрессии считается статистически незначимым. Н о не отклоняется.

Стандартная ошибка коэффициента регрессии

Для оценки существенности коэффициента регрессии его ве-личина сравнивается с его стандартной ошибкой, т. е. определяется фактическое значение t

-критерия Стьюдентa:  которое затем сравнивается с табличным значением при определенном уровне значимости и числе степеней свободы (n

- 2).

которое затем сравнивается с табличным значением при определенном уровне значимости и числе степеней свободы (n

- 2).

Стандартная ошибка параметра а :

Значимость линейного коэффициента корреляции проверя-ется на основе величины ошибки коэффициента корреляции т r:

Общая дисперсия признака х

:

Множественная линейная регрессия

Построение модели

Множественная регрессия представляет собой регрессию результативного признака с двумя и большим числом факторов, т. е. модель вида

Регрессия может дать хороший результат при модели-ровании, если влиянием других факторов, воздействующих на объект исследования, можно пренебречь. Поведение отдельных экономи-ческих переменных контролировать нельзя, т. е. не удается обес-печить равенство всех прочих условий для оценки влияния одно-го исследуемого фактора. В этом случае следует попытаться выявить влияние других факторов, введя их в модель, т. е. пост-роить уравнение множественной регрессии: y = a+b 1 x 1 +b 2 +…+b p x p + .

Основная цель множественной регрессии — построить модель с большим числом факторов, определив при этом влияние каждого из них в отдельности, а также совокупное их воздействие на моделируемый показатель. Спецификация модели включает в себя два круга вопросов: отбор фак-торов и выбор вида уравнения регрессии

Которое находит самое широкое применение в различных областях науки и практической деятельности. Это может быть физика, химия, биология, экономика, социология, психология и так далее, так далее. Волею судьбы мне часто приходится иметь дело с экономикой, и поэтому сегодня я оформлю вам путёвку в удивительную страну под названием Эконометрика =) …Как это не хотите?! Там очень хорошо – нужно только решиться! …Но вот то, что вы, наверное, определённо хотите – так это научиться решать задачи методом наименьших квадратов . И особо прилежные читатели научатся решать их не только безошибочно, но ещё и ОЧЕНЬ БЫСТРО;-) Но сначала общая постановка задачи + сопутствующий пример:

Пусть в некоторой предметной области исследуются показатели , которые имеют количественное выражение. При этом есть все основания полагать, что показатель зависит от показателя . Это полагание может быть как научной гипотезой, так и основываться на элементарном здравом смысле. Оставим, однако, науку в сторонке и исследуем более аппетитные области – а именно, продовольственные магазины. Обозначим через:

– торговую площадь продовольственного магазина, кв.м.,

– годовой товарооборот продовольственного магазина, млн. руб.

Совершенно понятно, что чем больше площадь магазина, тем в большинстве случаев будет больше его товарооборот.

Предположим, что после проведения наблюдений/опытов/подсчётов/танцев с бубном в нашем распоряжении оказываются числовые данные:

С гастрономами, думаю, всё понятно: – это площадь 1-го магазина, – его годовой товарооборот, – площадь 2-го магазина, – его годовой товарооборот и т.д. Кстати, совсем не обязательно иметь доступ к секретным материалам – довольно точную оценку товарооборота можно получить средствами математической статистики

. Впрочем, не отвлекаемся, курс коммерческого шпионажа – он уже платный =)

Табличные данные также можно записать в виде точек и изобразить в привычной для нас декартовой системе .

Ответим на важный вопрос: сколько точек нужно для качественного исследования?

Чем больше, тем лучше. Минимально допустимый набор состоит из 5-6 точек. Кроме того, при небольшом количестве данных в выборку нельзя включать «аномальные» результаты. Так, например, небольшой элитный магазин может выручать на порядки больше «своих коллег», искажая тем самым общую закономерность, которую и требуется найти!

Если совсем просто – нам нужно подобрать функцию , график

которой проходит как можно ближе к точкам ![]() . Такую функцию называют аппроксимирующей

(аппроксимация – приближение)

или теоретической функцией

. Вообще говоря, тут сразу появляется очевидный «претендент» – многочлен высокой степени, график которого проходит через ВСЕ точки. Но этот вариант сложен, а зачастую и просто некорректен (т.к. график будет всё время «петлять» и плохо отражать главную тенденцию)

.

. Такую функцию называют аппроксимирующей

(аппроксимация – приближение)

или теоретической функцией

. Вообще говоря, тут сразу появляется очевидный «претендент» – многочлен высокой степени, график которого проходит через ВСЕ точки. Но этот вариант сложен, а зачастую и просто некорректен (т.к. график будет всё время «петлять» и плохо отражать главную тенденцию)

.

Таким образом, разыскиваемая функция должна быть достаточно простА и в то же время отражать зависимость адекватно. Как вы догадываетесь, один из методов нахождения таких функций и называется методом наименьших квадратов

. Сначала разберём его суть в общем виде. Пусть некоторая функция приближает экспериментальные данные :

Как оценить точность данного приближения? Вычислим и разности (отклонения) между экспериментальными и функциональными значениями (изучаем чертёж)

. Первая мысль, которая приходит в голову – это оценить, насколько великА сумма , но проблема состоит в том, что разности могут быть и отрицательны (например, ![]() )

и отклонения в результате такого суммирования будут взаимоуничтожаться. Поэтому в качестве оценки точности приближения напрашивается принять сумму модулей

отклонений:

)

и отклонения в результате такого суммирования будут взаимоуничтожаться. Поэтому в качестве оценки точности приближения напрашивается принять сумму модулей

отклонений:

![]() или в свёрнутом виде: (вдруг кто не знает: – это значок суммы, а – вспомогательная переменная-«счётчик», которая принимает значения от 1 до )

.

или в свёрнутом виде: (вдруг кто не знает: – это значок суммы, а – вспомогательная переменная-«счётчик», которая принимает значения от 1 до )

.

Приближая экспериментальные точки различными функциями, мы будем получать разные значения , и очевидно, где эта сумма меньше – та функция и точнее.

Такой метод существует и называется он методом наименьших модулей . Однако на практике получил гораздо бОльшее распространение метод наименьших квадратов , в котором возможные отрицательные значения ликвидируются не модулем, а возведением отклонений в квадрат:

![]() , после чего усилия направлены на подбор такой функции , чтобы сумма квадратов отклонений

, после чего усилия направлены на подбор такой функции , чтобы сумма квадратов отклонений ![]() была как можно меньше. Собственно, отсюда и название метода.

была как можно меньше. Собственно, отсюда и название метода.

И сейчас мы возвращаемся к другому важному моменту: как отмечалось выше, подбираемая функция должна быть достаточно простА – но ведь и таких функций тоже немало: линейная , гиперболическая , экспоненциальная , логарифмическая , квадратичная и т.д. И, конечно же, тут сразу бы хотелось «сократить поле деятельности». Какой класс функций выбрать для исследования? Примитивный, но эффективный приём:

– Проще всего изобразить точки ![]() на чертеже и проанализировать их расположение. Если они имеют тенденцию располагаться по прямой, то следует искать уравнение прямой

на чертеже и проанализировать их расположение. Если они имеют тенденцию располагаться по прямой, то следует искать уравнение прямой

![]() с оптимальными значениями и . Иными словами, задача состоит в нахождении ТАКИХ коэффициентов – чтобы сумма квадратов отклонений была наименьшей.

с оптимальными значениями и . Иными словами, задача состоит в нахождении ТАКИХ коэффициентов – чтобы сумма квадратов отклонений была наименьшей.

Если же точки расположены, например, по гиперболе

, то заведомо понятно, что линейная функция будет давать плохое приближение. В этом случае ищем наиболее «выгодные» коэффициенты для уравнения гиперболы ![]() – те, которые дают минимальную сумму квадратов

– те, которые дают минимальную сумму квадратов  .

.

А теперь обратите внимание, что в обоих случаях речь идёт о функции двух переменных

, аргументами которой являются параметры разыскиваемых зависимостей

:

И по существу нам требуется решить стандартную задачу – найти минимум функции двух переменных .

Вспомним про наш пример: предположим, что «магазинные» точки имеют тенденцию располагаться по прямой линии и есть все основания полагать наличие линейной зависимости

товарооборота от торговой площади. Найдём ТАКИЕ коэффициенты «а» и «бэ», чтобы сумма квадратов отклонений ![]() была наименьшей. Всё как обычно – сначала частные производные 1-го порядка

. Согласно правилу линейности

дифференцировать можно прямо под значком суммы:

была наименьшей. Всё как обычно – сначала частные производные 1-го порядка

. Согласно правилу линейности

дифференцировать можно прямо под значком суммы:

Если хотите использовать данную информацию для реферата или курсовика – буду очень благодарен за поставленную ссылку в списке источников, такие подробные выкладки найдёте мало где:

Составим стандартную систему:

Сокращаем каждое уравнение на «двойку» и, кроме того, «разваливаем» суммы:

Примечание

: самостоятельно проанализируйте, почему «а» и «бэ» можно вынести за значок суммы. Кстати, формально это можно проделать и с суммой

![]()

Перепишем систему в «прикладном» виде:

после чего начинает прорисовываться алгоритм решения нашей задачи:

Координаты точек мы знаем? Знаем. Суммы ![]() найти можем? Легко. Составляем простейшую систему двух линейных уравнений с двумя неизвестными

(«а» и «бэ»). Систему решаем, например, методом Крамера

, в результате чего получаем стационарную точку . Проверяя достаточное условие экстремума

, можно убедиться, что в данной точке функция

найти можем? Легко. Составляем простейшую систему двух линейных уравнений с двумя неизвестными

(«а» и «бэ»). Систему решаем, например, методом Крамера

, в результате чего получаем стационарную точку . Проверяя достаточное условие экстремума

, можно убедиться, что в данной точке функция ![]() достигает именно минимума

. Проверка сопряжена с дополнительными выкладками и поэтому оставим её за кадром (при необходимости недостающий кадр можно посмотреть )

. Делаем окончательный вывод:

достигает именно минимума

. Проверка сопряжена с дополнительными выкладками и поэтому оставим её за кадром (при необходимости недостающий кадр можно посмотреть )

. Делаем окончательный вывод:

Функция ![]() наилучшим образом (по крайне мере, по сравнению с любой другой линейной функцией)

приближает экспериментальные точки

наилучшим образом (по крайне мере, по сравнению с любой другой линейной функцией)

приближает экспериментальные точки ![]() . Грубо говоря, её график проходит максимально близко к этим точкам. В традициях эконометрики

полученную аппроксимирующую функцию также называют уравнением пАрной линейной регрессии

.

. Грубо говоря, её график проходит максимально близко к этим точкам. В традициях эконометрики

полученную аппроксимирующую функцию также называют уравнением пАрной линейной регрессии

.

Рассматриваемая задача имеет большое практическое значение. В ситуации с нашим примером, уравнение ![]() позволяет прогнозировать, какой товарооборот («игрек»)

будет у магазина при том или ином значении торговой площади (том или ином значении «икс»)

. Да, полученный прогноз будет лишь прогнозом, но во многих случаях он окажется достаточно точным.

позволяет прогнозировать, какой товарооборот («игрек»)

будет у магазина при том или ином значении торговой площади (том или ином значении «икс»)

. Да, полученный прогноз будет лишь прогнозом, но во многих случаях он окажется достаточно точным.

Я разберу всего лишь одну задачу с «реальными» числами, поскольку никаких трудностей в ней нет – все вычисления на уровне школьной программы 7-8 класса. В 95 процентов случаев вам будет предложено отыскать как раз линейную функцию, но в самом конце статьи я покажу, что ничуть не сложнее отыскать уравнения оптимальной гиперболы, экспоненты и некоторых других функций.

По сути, осталось раздать обещанные плюшки – чтобы вы научились решать такие примеры не только безошибочно, но ещё и быстро. Внимательно изучаем стандарт:

Задача

В результате исследования взаимосвязи двух показателей, получены следующие пары чисел:

Методом наименьших квадратов найти линейную функцию, которая наилучшим образом приближает эмпирические (опытные)

данные. Сделать чертеж, на котором в декартовой прямоугольной системе координат построить экспериментальные точки и график аппроксимирующей функции ![]() . Найти сумму квадратов отклонений между эмпирическими и теоретическими значениями. Выяснить, будет ли функция лучше (с точки зрения метода наименьших квадратов)

приближать экспериментальные точки.

. Найти сумму квадратов отклонений между эмпирическими и теоретическими значениями. Выяснить, будет ли функция лучше (с точки зрения метода наименьших квадратов)

приближать экспериментальные точки.

Заметьте, что «иксовые» значения – натуральные, и это имеет характерный содержательный смысл, о котором я расскажу чуть позже; но они, разумеется, могут быть и дробными. Кроме того, в зависимости от содержания той или иной задачи как «иксовые», так и «игрековые» значения полностью или частично могут быть отрицательными. Ну а у нас дана «безликая» задача, и мы начинаем её решение :

Коэффициенты оптимальной функции найдём как решение системы:

В целях более компактной записи переменную-«счётчик» можно опустить, поскольку и так понятно, что суммирование осуществляется от 1 до .

Расчёт нужных сумм удобнее оформить в табличном виде:

Вычисления можно провести на микрокалькуляторе, но гораздо лучше использовать Эксель – и быстрее, и без ошибок; смотрим короткий видеоролик:

Таким образом, получаем следующую систему

:![]()

Тут можно умножить второе уравнение на 3 и из 1-го уравнения почленно вычесть 2-е

. Но это везение – на практике системы чаще не подарочны, и в таких случаях спасает метод Крамера

:

, значит, система имеет единственное решение.

Выполним проверку. Понимаю, что не хочется, но зачем же пропускать ошибки там, где их можно стопроцентно не пропустить? Подставим найденное решение в левую часть каждого уравнения системы:

Получены правые части соответствующих уравнений, значит, система решена правильно.

Таким образом, искомая аппроксимирующая функция: – из всех линейных функций экспериментальные данные наилучшим образом приближает именно она.

В отличие от прямой

зависимости товарооборота магазина от его площади, найденная зависимость является обратной

(принцип «чем больше – тем меньше»)

, и этот факт сразу выявляется по отрицательному угловому коэффициенту

. Функция ![]() сообщает нам о том, что с увеличение некоего показателя на 1 единицу значение зависимого показателя уменьшается в среднем

на 0,65 единиц. Как говорится, чем выше цена на гречку, тем меньше её продано.

сообщает нам о том, что с увеличение некоего показателя на 1 единицу значение зависимого показателя уменьшается в среднем

на 0,65 единиц. Как говорится, чем выше цена на гречку, тем меньше её продано.

Для построения графика аппроксимирующей функции найдём два её значения:

и выполним чертёж:

Построенная прямая называется линией тренда

(а именно – линией линейного тренда, т.е. в общем случае тренд – это не обязательно прямая линия)

. Всем знакомо выражение «быть в тренде», и, думаю, что этот термин не нуждается в дополнительных комментариях.

Вычислим сумму квадратов отклонений ![]() между эмпирическими и теоретическими значениями. Геометрически – это сумма квадратов длин «малиновых» отрезков (два из которых настолько малы, что их даже не видно)

.

между эмпирическими и теоретическими значениями. Геометрически – это сумма квадратов длин «малиновых» отрезков (два из которых настолько малы, что их даже не видно)

.

Вычисления сведём в таблицу:

Их можно опять же провести вручную, на всякий случай приведу пример для 1-й точки:![]()

но намного эффективнее поступить уже известным образом:

Еще раз повторим: в чём смысл полученного результата?

Из всех линейных функций

у функции ![]() показатель является наименьшим, то есть в своём семействе это наилучшее приближение. И здесь, кстати, не случаен заключительный вопрос задачи: а вдруг предложенная экспоненциальная функция

показатель является наименьшим, то есть в своём семействе это наилучшее приближение. И здесь, кстати, не случаен заключительный вопрос задачи: а вдруг предложенная экспоненциальная функция ![]() будет лучше приближать экспериментальные точки?

будет лучше приближать экспериментальные точки?

Найдем соответствующую сумму квадратов отклонений – чтобы различать, я обозначу их буквой «эпсилон». Техника точно такая же:

И снова на всякий пожарный вычисления для 1-й точки:

В Экселе пользуемся стандартной функцией EXP

(синтаксис можно посмотреть в экселевской Справке)

.

Вывод

: , значит, экспоненциальная функция приближает экспериментальные точки хуже, чем прямая ![]() .

.

Но тут следует отметить, что «хуже» – это ещё не значит

, что плохо. Сейчас построил график этой экспоненциальной функции – и он тоже проходит близко к точкам ![]() – да так, что без аналитического исследования и сказать трудно, какая функция точнее.

– да так, что без аналитического исследования и сказать трудно, какая функция точнее.

На этом решение закончено, и я возвращаюсь к вопросу о натуральных значениях аргумента. В различных исследованиях, как правило, экономических или социологических, натуральными «иксами» нумеруют месяцы, годы или иные равные временнЫе промежутки. Рассмотрим, например, такую задачу.

Задача заключается в нахождении коэффициентов линейной зависимости, при которых функция двух переменных а и b принимает наименьшее значение. То есть, при данных а и b сумма квадратов отклонений экспериментальных данных от найденной прямой будет наименьшей. В этом вся суть метода наименьших квадратов.

Таким образом, решение примера сводится к нахождению экстремума функции двух переменных.

Вывод формул для нахождения коэффициентов.

Составляется и решается система из двух уравнений с двумя неизвестными. Находим частные производные функции ![]() по переменным а

и b

, приравниваем эти производные к нулю.

по переменным а

и b

, приравниваем эти производные к нулю.

Решаем полученную систему уравнений любым методом (например методом подстановки или методом Крамера) и получаем формулы для нахождения коэффициентов по методу наименьших квадратов (МНК).

При данных а

и b

функция ![]() принимает наименьшее значение.

принимает наименьшее значение.

Вот и весь метод наименьших квадратов. Формула для нахождения параметра a содержит суммы , , , и параметр n - количество экспериментальных данных. Значения этих сумм рекомендуем вычислять отдельно. Коэффициент b находится после вычисления a .

Основная сфера применения таких полиномов - обработка экспериментальных данных (построение эмпирических формул). Дело в том, что интерполяционный полином, построенный по значениям функции, полученным с помощью эксперимента, будет испытывать сильное влияние "экспериментального шума", к тому же при интерполировании узлы интерполяции не могут повторяться, т.е. нельзя использовать результаты повторных экспериментов при одинаковых условиях. Среднеквадратичный же полином сглаживает шумы и позволяет использовать результаты многократных экспериментов.

Численное интегрирование и дифференцирование. Пример.

Численное интегрирование – вычисление значения определённого интеграла (как правило, приближённое). Под численным интегрированием понимают набор численных методов для нахождения значения определённого интеграла.

Численное дифференцирование – совокупность методов вычисления значения производной дискретно заданной функции.

Интегрирование

Постановка задачи. Математическая постановка задачи: необходимо найти значение определенного интеграла

где a, b - конечны, f(x) - непрерывна на [а, b].

При решении практических задач часто бывает, что интеграл неудобно или невозможно взять аналитически: он может не выражаться в элементарных функциях, подынтегральная функция может быть задана в виде таблицы и пр. В таких случаях применяют методы численного интегрирования. Численные методы интегрирования используют замену площади криволинейной трапеции на конечную сумму площадей более простых геометрических фигур, которые могут быть вычислены точно. В этом смысле говорят об использовании квадратурных формул.

В большинстве методов используется представление интеграла в виде конечной суммы (квадратурная формула):

В основе квадратурных формул лежит идея замена на отрезке интегрирования графика подынтегрального выражения функциями более простого вида, которые легко могут быть проинтегрированы аналитически и, таким образом, легко вычислены. Наиболее просто задача построения квадратурных формул реализуется для полиномиальных математических моделей.

Можно выделить три группы методов:

1. Метод с разбиением отрезка интегрирования на равные интервалы. Разбиение на интервалы производится заранее, обычно интервалы выбираются равными (чтобы легче было вычислить функцию на концах интервалов). Вычисляют площади и суммируют их (методы прямоугольников, трапеции, Симпсона).

2. Методы с разбиением отрезка интегрирования с помощью специальных точек (метод Гаусса).

3. Вычисление интегралов с помощью случайных чисел (метод Монте-Карло).

Метод прямоугольников. Пусть функцию (рисунок) необходимо проинтегрировать численным методом на отрезке . Разделим отрезок на N равных интервалов. Площадь каждой из N криволинейных трапеций можно заменить на площадь прямоугольника.

Ширина всех прямоугольников одинакова и равна:

![]()

В качестве выбора высоты прямоугольников можно выбрать значение функции на левой границе. В этом случае высота первого прямоугольника составит f(a), второго – f(x 1),…, N-f(N-1).

Если в качестве выбора высоты прямоугольника взять значение функции на правой границе, то в этом случае высота первого прямоугольника составит f(x 1), второго – f(x 2), …, N – f(x N).

Как видно, в этом случае одна из формул дает приближение к интегралу с избытком, а вторая с недостатком. Существует еще один способ – использовать для аппроксимации значение функции в середине отрезка интегрирования:

Оценка абсолютной погрешности метода прямоугольников (середина)

Оценка абсолютной погрешности методов левых и правых прямоугольников.

Пример. Вычислить для всего интервала и с делением интервала на четыре участка

Решение. Аналитическое вычисление данного интеграла дает I=агсtg(1)–агсtg(0)=0,7853981634. В нашем случае:

1)h = 1; xо = 0; x1 = 1;

2) h = 0,25 (1/4); x0 = 0; x1 = 0,25; x2 = 0,5; х3 = 0,75; x4 = 1;

Вычислим методом левых прямоугольников:

![]()

Вычислим методом правых прямоугольников:

![]()

Вычислим методом средних прямоугольников:

![]()

Метод трапеций. Использование для интерполяции полинома первой степени (прямая линия, проведенная через две точки) приводит к формуле трапеций. В качестве узлов интерполирования берутся концы отрезка интегрирования. Таким образом, криволинейная трапеция заменяется на обычную трапецию, площадь которой может быть найдена как произведение полусуммы оснований на высоту

![]() В случае N отрезков интегрирования для всех узлов, за исключением крайних точек отрезка, значение функции войдет в общую сумму дважды (так как соседние трапеции имеют одну общую сторону)

В случае N отрезков интегрирования для всех узлов, за исключением крайних точек отрезка, значение функции войдет в общую сумму дважды (так как соседние трапеции имеют одну общую сторону)

![]()

Формула трапеции может быть получена, если взять половину суммы формул прямоугольников по правому и левому краям отрезка:

Проверка устойчивости решения. Как правило, чем меньше длина каждого интервала, т.е. чем больше число этих интервалов, тем меньше различаются приближенное и точное значение интеграла. Это справедливо для большинства функций. В методе трапеций ошибка вычисления интеграла ϭ приблизительно пропорциональна квадрату шага интегрирования (ϭ ~ h 2).Таким образом, для вычисления интеграла некоторой функции в переделах a,b необходимо разделить отрезок на N 0 интервалов и найти сумму площадей трапеции. Затем нужно увеличить число интервалов N 1 , опять вычислить сумму трапеции и сравнить полученное значение с предыдущим результатом. Это следует повторять до тех пор (N i), пока не будет достигнута заданная точность результата (критерий сходимости).

Для методов прямоугольников и трапеции обычно на каждом шаге итерации число интервалов увеличивается в 2 раза (N i +1 =2N i).

Критерий сходимости:

Главное преимущество правила трапеций – его простота. Однако если при вычислении интеграла требуется высокая точность, применение этого метода может потребовать слишком большого количества итераций.

Абсолютная погрешность метода трапеций

оценивается как

.

Пример. Вычислить приближенно определенный интеграл по формуле трапеций.

а) Разбив отрезок интегрирования на 3 части.

б) Разбив отрезок интегрирования на 5 частей.

Решение:

а) По условию отрезок интегрирования нужно разделить на 3 части, то есть .

Вычислим длину каждого отрезка разбиения: ![]() .

.

Таким образом, общая формула трапеций сокращается до приятных размеров:

Окончательно:

Напоминаю, что полученное значение – это приближенное значение площади.

б) Разобьём отрезок интегрирования на 5 равных частей, то есть . увеличивая количество отрезков, мы увеличиваем точность вычислений.

Если , то формула трапеций принимает следующий вид:

Найдем шаг разбиения:![]() , то есть, длина каждого промежуточного отрезка равна 0,6.

, то есть, длина каждого промежуточного отрезка равна 0,6.

При чистовом оформлении задачи все вычисления удобно оформлять расчетной таблицей:

В первой строке записываем «счётчик»

В результате:

Ну что же, уточнение, и серьёзное, действительно есть!

Если для 3-х отрезков разбиения , то для 5-ти отрезков . Если взять еще больше отрезком => будет еще точнее.

Формула Симпсона. Формула трапеции дает результат, сильно зависящий от величины шага h, что сказывается на точности вычисления определенного интеграла особенно в тех случаях, когда функция имеет немонотонный характер. Можно предположить повышение точности вычислений, если вместо отрезков прямых, заменяющих криволинейные фрагменты графика функции f(x), использовать, например, фрагменты парабол, приводимых через три соседние точки графика. Подобная геометрическая интерпретация лежит в основе метода Симпсона для вычисления определенного интеграла. Весь интервал интегрирования a,b разбивается N отрезков, длина отрезка также будет равна h=(b-a)/N.

Формула Симпсона имеет вид:

![]() остаточный член

остаточный член

С увеличением длины отрезков точность формулы падает, поэтому для увеличения точности применяют составную формулу Симпсона. Весь интервал интегрирования разбивается на четное число одинаковых отрезков N, длина отрезка также будет равна h=(b-a)/N. Составная формула Симпсона имеет вид:

В формуле выражения в скобках представляют собой суммы значений подынтегральной функции соответственно на концах нечетных и четных внутренних отрезков.

Остаточный член формулы Симпсона пропорционален уже четвертой степени шага:

![]()

Пример: Пользуясь правилом Симпсона вычислить интеграл . (Точное решение - 0,2)

Метод Гаусса

Квадратурная формула Гаусса

. Основной принцип квадратурных формул второй разновидности виден из рисунка 1.12: необходимо так разместить точки х

0 и х

1 внутри отрезка [a

;b

], чтобы площади "треугольников" в сумме были равны площади "сегмента". При использовании формулы Гаусса исходный отрезок [a

;b

] сводится к отрезку [-1;1] заменой переменной х

на

Квадратурная формула Гаусса

. Основной принцип квадратурных формул второй разновидности виден из рисунка 1.12: необходимо так разместить точки х

0 и х

1 внутри отрезка [a

;b

], чтобы площади "треугольников" в сумме были равны площади "сегмента". При использовании формулы Гаусса исходный отрезок [a

;b

] сводится к отрезку [-1;1] заменой переменной х

на

0.5∙(b – a )∙t + 0.5∙(b + a ).

Тогда ![]() , где

, где ![]() .

.

Такая замена возможна, если a и b конечны, а функция f (x ) непрерывна на [a ;b ]. Формула Гаусса при n точках x i , i =0,1,..,n -1 внутри отрезка [a ;b ]:

, (1.27)

, (1.27)

где t i

и A i

для различных n

приводятся в справочниках. Например, при n

=2 ![]() A

0 =A

1 =1; при n

=3: t

0 =t

2 »0.775, t

1 =0, A

0 =A

2 »0.555, A

1 »0.889.

A

0 =A

1 =1; при n

=3: t

0 =t

2 »0.775, t

1 =0, A

0 =A

2 »0.555, A

1 »0.889.

Квадратурная формула Гаусса

получена с весовой функцией равной единице p(x)=

1 и узлами x i

, являющимися корнями полиномов Лежандра

получена с весовой функцией равной единице p(x)=

1 и узлами x i

, являющимися корнями полиномов Лежандра

![]()

Коэффициенты A i легко вычисляются по формулам

![]() i

=0,1,2,...n

.

i

=0,1,2,...n

.

Значения узлов и коэффициентов для n=2,3,4,5 приведены в таблице

| Порядок | Узлы | Коэффициенты |

| n =2 | x 1 =0 x 0 = -x 2 =0.7745966692 | A 1 =8/9 A 0 =A 2 =5/9 |

| n =3 | x 2 = -x 1 =0.3399810436 x 3 = -x 0 =0.8611363116 | A 1 =A 2 =0.6521451549 A 0 =A 3 =0.6521451549 |

| n=4 | x 2 = 0 x 3 = -x 1 = 0.5384693101 x 4 =-x 0 =0.9061798459 | A 0 =0.568888899 A 3 =A 1 =0.4786286705 A 0 =A 4 =0.2869268851 |

| n =5 | x 5 = -x 0 =0.9324695142 x 4 = -x 1 =0.6612093865 x 3 = -x 2 =0.2386191861 | A 5 =A 0 =0.1713244924 A 4 =A 1 =0.3607615730 A 3 =A 2 =0.4679139346 |

Пример. Вычислить значение по формуле Гаусса для n =2:

Точное значение: ![]() .

.

Алгоритм вычисления интеграла по формуле Гаусса предусматривает не удвоение числа микроотрезков, а увеличение числа ординат на 1 и сравнение полученных значений интеграла. Преимущество формулы Гаусса – высокая точность при сравнительно малом числе ординат. Недостатки: неудобна при расчетах вручную; необходимо держать в памяти ЭВМ значения t i , A i для различных n .

Погрешность квадратурной формулы Гаусса на отрезке будет при этом Для формула остаточного члена будет причем коэффициент α N

быстро убывает с ростом N

. Здесь ![]()

Формулы Гаусса обеспечивают высокую точность уже при небольшом количестве узлов (от 4 до 10) В этом случае В практических же вычислениях число узлов составляет от нескольких сотен до нескольких тысяч. Отметим также, что веса квадратур Гаусса всегда положительны, что обеспечивает устойчивость алгоритма вычисления сумм

Дифференцирование. При решении задач часто бывает необходимо найти производную определенного порядка от функции f(x), заданной таблично. Кроме того, иногда в силу сложности аналитического выражения функции f(x) ее непосредственное дифференцирование слишком затрудненно, а также при численном решении дифференциальных уравнений. В этих случаях используют численное дифференцирование.

Метод наименьших квадратов

Метод наименьших квадратов (МНК, OLS, Ordinary Least Squares ) - один из базовых методов регрессионного анализа для оценки неизвестных параметров регрессионных моделей по выборочным данным. Метод основан на минимизации суммы квадратов остатков регрессии.

Необходимо отметить, что собственно методом наименьших квадратов можно назвать метод решения задачи в любой области, если решение заключается или удовлетворяет некоторому критерию минимизации суммы квадратов некоторых функций от искомых переменных. Поэтому метод наименьших квадратов может применяться также для приближённого представления (аппроксимации) заданной функции другими (более простыми) функциями, при нахождении совокупности величин, удовлетворяющих уравнениям или ограничениям, количество которых превышает количество этих величин и т. д.

Сущность МНК

Пусть задана некоторая (параметрическая) модель вероятностной (регрессионной) зависимости между (объясняемой) переменной y и множеством факторов (объясняющих переменных) x

где - вектор неизвестных параметров модели

- случайная ошибка модели.Пусть также имеются выборочные наблюдения значений указанных переменных. Пусть - номер наблюдения (). Тогда - значения переменных в -м наблюдении. Тогда при заданных значениях параметров b можно рассчитать теоретические (модельные) значения объясняемой переменной y:

Величина остатков зависит от значений параметров b.

Сущность МНК (обычного, классического) заключается в том, чтобы найти такие параметры b, при которых сумма квадратов остатков (англ. Residual Sum of Squares ) будет минимальной:

В общем случае решение этой задачи может осуществляться численными методами оптимизации (минимизации). В этом случае говорят о нелинейном МНК (NLS или NLLS - англ. Non-Linear Least Squares ). Во многих случаях можно получить аналитическое решение. Для решения задачи минимизации необходимо найти стационарные точки функции , продифференцировав её по неизвестным параметрам b, приравняв производные к нулю и решив полученную систему уравнений:

Если случайные ошибки модели имеют нормальное распределение , имеют одинаковую дисперсию и некоррелированы между собой, МНК-оценки параметров совпадают с оценками метода максимального правдоподобия (ММП) .

МНК в случае линейной модели

Пусть регрессионная зависимость является линейной:

Пусть y - вектор-столбец наблюдений объясняемой переменной, а - матрица наблюдений факторов (строки матрицы - векторы значений факторов в данном наблюдении, по столбцам - вектор значений данного фактора во всех наблюдениях). Матричное представление линейной модели имеет вид:

Тогда вектор оценок объясняемой переменной и вектор остатков регрессии будут равны

соответственно сумма квадратов остатков регрессии будет равна

Дифференцируя эту функцию по вектору параметров и приравняв производные к нулю, получим систему уравнений (в матричной форме):

.Решение этой системы уравнений и дает общую формулу МНК-оценок для линейной модели:

Для аналитических целей оказывается полезным последнее представление этой формулы. Если в регрессионной модели данные центрированы , то в этом представлении первая матрица имеет смысл выборочной ковариационной матрицы факторов, а вторая - вектор ковариаций факторов с зависимой переменной. Если кроме того данные ещё и нормированы на СКО (то есть в конечном итоге стандартизированы ), то первая матрица имеет смысл выборочной корреляционной матрицы факторов, второй вектор - вектора выборочных корреляций факторов с зависимой переменной.

Немаловажное свойство МНК-оценок для моделей с константой - линия построенной регрессии проходит через центр тяжести выборочных данных, то есть выполняется равенство:

В частности, в крайнем случае, когда единственным регрессором является константа, получаем, что МНК-оценка единственного параметра (собственно константы) равна среднему значению объясняемой переменной. То есть среднее арифметическое, известное своими хорошими свойствами из законов больших чисел, также является МНК-оценкой - удовлетворяет критерию минимума суммы квадратов отклонений от неё.

Пример: простейшая (парная) регрессия

В случае парной линейной регрессии формулы расчета упрощаются (можно обойтись без матричной алгебры):

Свойства МНК-оценок

В первую очередь, отметим, что для линейных моделей МНК-оценки являются линейными оценками, как это следует из вышеприведённой формулы. Для несмещенности МНК-оценок необходимо и достаточно выполнения важнейшего условия регрессионного анализа : условное по факторам математическое ожидание случайной ошибки должно быть равно нулю. Данное условие, в частности, выполнено, если

- математическое ожидание случайных ошибок равно нулю, и

- факторы и случайные ошибки - независимые случайные величины.

Второе условие - условие экзогенности факторов - принципиальное. Если это свойство не выполнено, то можно считать, что практически любые оценки будут крайне неудовлетворительными: они не будут даже состоятельными (то есть даже очень большой объём данных не позволяет получить качественные оценки в этом случае). В классическом случае делается более сильное предположение о детерминированности факторов, в отличие от случайной ошибки, что автоматически означает выполнение условия экзогенности. В общем случае для состоятельности оценок достаточно выполнения условия экзогенности вместе со сходимостью матрицы к некоторой невырожденной матрице при увеличении объёма выборки до бесконечности.

Для того, чтобы кроме состоятельности и несмещенности , оценки (обычного) МНК были ещё и эффективными (наилучшими в классе линейных несмещенных оценок) необходимо выполнение дополнительных свойств случайной ошибки:

Данные предположения можно сформулировать для ковариационной матрицы вектора случайных ошибок

Линейная модель, удовлетворяющая таким условиям, называется классической . МНК-оценки для классической линейной регрессии являются несмещёнными , состоятельными и наиболее эффективными оценками в классе всех линейных несмещённых оценок (в англоязычной литературе иногда употребляют аббревиатуру BLUE (Best Linear Unbaised Estimator ) - наилучшая линейная несмещённая оценка; в отечественной литературе чаще приводится теорема Гаусса - Маркова). Как нетрудно показать, ковариационная матрица вектора оценок коэффициентов будет равна:

Обобщенный МНК

Метод наименьших квадратов допускает широкое обобщение. Вместо минимизации суммы квадратов остатков можно минимизировать некоторую положительно определенную квадратичную форму от вектора остатков , где - некоторая симметрическая положительно определенная весовая матрица. Обычный МНК является частным случаем данного подхода, когда весовая матрица пропорциональна единичной матрице. Как известно из теории симметрических матриц (или операторов) для таких матриц существует разложение . Следовательно, указанный функционал можно представить следующим образом , то есть этот функционал можно представить как сумму квадратов некоторых преобразованных «остатков». Таким образом, можно выделить класс методов наименьших квадратов - LS-методы (Least Squares).

Доказано (теорема Айткена), что для обобщенной линейной регрессионной модели (в которой на ковариационную матрицу случайных ошибок не налагается никаких ограничений) наиболее эффективными (в классе линейных несмещенных оценок) являются оценки т. н. обобщенного МНК (ОМНК, GLS - Generalized Least Squares) - LS-метода с весовой матрицей, равной обратной ковариационной матрице случайных ошибок: .

Можно показать, что формула ОМНК-оценок параметров линейной модели имеет вид

Ковариационная матрица этих оценок соответственно будет равна

Фактически сущность ОМНК заключается в определенном (линейном) преобразовании (P) исходных данных и применении обычного МНК к преобразованным данным. Цель этого преобразования - для преобразованных данных случайные ошибки уже удовлетворяют классическим предположениям.

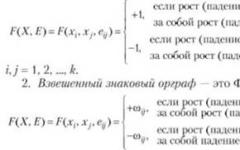

Взвешенный МНК

В случае диагональной весовой матрицы (а значит и ковариационной матрицы случайных ошибок) имеем так называемый взвешенный МНК (WLS - Weighted Least Squares). В данном случае минимизируется взвешенная сумма квадратов остатков модели, то есть каждое наблюдение получает «вес», обратно пропорциональный дисперсии случайной ошибки в данном наблюдении: . Фактически данные преобразуются взвешиванием наблюдений (делением на величину, пропорциональную предполагаемому стандартному отклонению случайных ошибок), а к взвешенным данным применяется обычный МНК.

Некоторые частные случаи применения МНК на практике

Аппроксимация линейной зависимости

Рассмотрим случай, когда в результате изучения зависимости некоторой скалярной величины от некоторой скалярной величины (Это может быть, например, зависимость напряжения от силы тока : , где - постоянная величина, сопротивление проводника) было проведено измерений этих величин, в результате которых были получены значения и соответствующие им значения . Данные измерений должны быть записаны в таблице.

Таблица. Результаты измерений.

| № измерения | ||

|---|---|---|

| 1 | ||

| 2 | ||

| 3 | ||

| 4 | ||

| 5 | ||

| 6 |

Вопрос звучит так: какое значение коэффициента можно подобрать, чтобы наилучшим образом описать зависимость ? Согласно МНК это значение должно быть таким, чтобы сумма квадратов отклонений величин от величин

была минимальной

Сумма квадратов отклонений имеет один экстремум - минимум, что позволяет нам использовать эту формулу . Найдём из этой формулы значение коэффициента . Для этого преобразуем её левую часть следующим образом:

Последняя формула позволяет нам найти значение коэффициента , что и требовалось в задаче.

История

До начала XIX в. учёные не имели определённых правил для решения системы уравнений , в которой число неизвестных меньше, чем число уравнений; до этого времени употреблялись частные приёмы, зависевшие от вида уравнений и от остроумия вычислителей, и потому разные вычислители, исходя из тех же данных наблюдений, приходили к различным выводам. Гауссу (1795) принадлежит первое применение метода, а Лежандр (1805) независимо открыл и опубликовал его под современным названием (фр. Méthode des moindres quarrés ) . Лаплас связал метод с теорией вероятностей , а американский математик Эдрейн (1808) рассмотрел его теоретико-вероятностные приложения . Метод распространён и усовершенствован дальнейшими изысканиями Энке , Бесселя , Ганзена и других.

Альтернативное использование МНК

Идея метода наименьших квадратов может быть использована также в других случаях, не связанных напрямую с регрессионным анализом. Дело в том, что сумма квадратов является одной из наиболее распространенных мер близости для векторов (евклидова метрика в конечномерных пространствах).

Одно из применений - «решение» систем линейных уравнений, в которых число уравнений больше числа переменных

где матрица не квадратная, а прямоугольная размера .

Такая система уравнений, в общем случае не имеет решения (если ранг на самом деле больше числа переменных). Поэтому эту систему можно «решить» только в смысле выбора такого вектора , чтобы минимизировать «расстояние» между векторами и . Для этого можно применить критерий минимизации суммы квадратов разностей левой и правой частей уравнений системы, то есть . Нетрудно показать, что решение этой задачи минимизации приводит к решению следующей системы уравнений

Метод наименьших квадратов (МНК, англ. Ordinary Least Squares, OLS ) - математический метод, применяемый для решения различных задач, основанный на минимизации суммы квадратов отклонений некоторых функций от искомых переменных. Он может использоваться для «решения» переопределенных систем уравнений (когда количество уравнений превышает количество неизвестных), для поиска решения в случае обычных (не переопределенных) нелинейных систем уравнений, для аппроксимации точечных значений некоторой функции. МНК является одним из базовых методов регрессионного анализа для оценки неизвестных параметров регрессионных моделей по выборочным данным.

Энциклопедичный YouTube

1 / 5

✪ Метод наименьших квадратов. Тема

✪ Митин И. В. - Обработка результатов физ. эксперимента - Метод наименьших квадратов (Лекция 4)

✪ Метод наименьших квадратов, урок 1/2. Линейная функция

✪ Эконометрика. Лекция 5 .Метод наименьших квадратов

✪ Метод наименьших квадратов. Ответы

Субтитры

История

До начала XIX в. учёные не имели определённых правил для решения системы уравнений , в которой число неизвестных меньше, чем число уравнений; до этого времени употреблялись частные приёмы, зависевшие от вида уравнений и от остроумия вычислителей, и потому разные вычислители, исходя из тех же данных наблюдений, приходили к различным выводам. Гауссу (1795) принадлежит первое применение метода, а Лежандр (1805) независимо открыл и опубликовал его под современным названием (фр. Méthode des moindres quarrés ) . Лаплас связал метод с теорией вероятностей , а американский математик Эдрейн (1808) рассмотрел его теоретико-вероятностные приложения . Метод распространён и усовершенствован дальнейшими изысканиями Энке , Бесселя , Ганзена и других.

Сущность метода наименьших квадратов

Пусть x {\displaystyle x} - набор n {\displaystyle n} неизвестных переменных (параметров), f i (x) {\displaystyle f_{i}(x)} , , m > n {\displaystyle m>n} - совокупность функций от этого набора переменных. Задача заключается в подборе таких значений x {\displaystyle x} , чтобы значения этих функций были максимально близки к некоторым значениям y i {\displaystyle y_{i}} . По существу речь идет о «решении» переопределенной системы уравнений f i (x) = y i {\displaystyle f_{i}(x)=y_{i}} , i = 1 , … , m {\displaystyle i=1,\ldots ,m} в указанном смысле максимальной близости левой и правой частей системы. Сущность МНК заключается в выборе в качестве «меры близости» суммы квадратов отклонений левых и правых частей | f i (x) − y i | {\displaystyle |f_{i}(x)-y_{i}|} . Таким образом, сущность МНК может быть выражена следующим образом:

∑ i e i 2 = ∑ i (y i − f i (x)) 2 → min x {\displaystyle \sum _{i}e_{i}^{2}=\sum _{i}(y_{i}-f_{i}(x))^{2}\rightarrow \min _{x}} .В случае, если система уравнений имеет решение, то минимум суммы квадратов будет равен нулю и могут быть найдены точные решения системы уравнений аналитически или, например, различными численными методами оптимизации. Если система переопределена, то есть, говоря нестрого, количество независимых уравнений больше количества искомых переменных, то система не имеет точного решения и метод наименьших квадратов позволяет найти некоторый «оптимальный» вектор x {\displaystyle x} в смысле максимальной близости векторов y {\displaystyle y} и f (x) {\displaystyle f(x)} или максимальной близости вектора отклонений e {\displaystyle e} к нулю (близость понимается в смысле евклидова расстояния).

Пример - система линейных уравнений

В частности, метод наименьших квадратов может использоваться для «решения» системы линейных уравнений

A x = b {\displaystyle Ax=b} ,где A {\displaystyle A} прямоугольная матрица размера m × n , m > n {\displaystyle m\times n,m>n} (т.е. число строк матрицы A больше количества искомых переменных).

Такая система уравнений в общем случае не имеет решения. Поэтому эту систему можно «решить» только в смысле выбора такого вектора x {\displaystyle x} , чтобы минимизировать «расстояние» между векторами A x {\displaystyle Ax} и b {\displaystyle b} . Для этого можно применить критерий минимизации суммы квадратов разностей левой и правой частей уравнений системы, то есть (A x − b) T (A x − b) → min {\displaystyle (Ax-b)^{T}(Ax-b)\rightarrow \min } . Нетрудно показать, что решение этой задачи минимизации приводит к решению следующей системы уравнений

A T A x = A T b ⇒ x = (A T A) − 1 A T b {\displaystyle A^{T}Ax=A^{T}b\Rightarrow x=(A^{T}A)^{-1}A^{T}b} .МНК в регрессионном анализе (аппроксимация данных)

Пусть имеется n {\displaystyle n} значений некоторой переменной y {\displaystyle y} (это могут быть результаты наблюдений, экспериментов и т. д.) и соответствующих переменных x {\displaystyle x} . Задача заключается в том, чтобы взаимосвязь между y {\displaystyle y} и x {\displaystyle x} аппроксимировать некоторой функцией , известной с точностью до некоторых неизвестных параметров b {\displaystyle b} , то есть фактически найти наилучшие значения параметров b {\displaystyle b} , максимально приближающие значения f (x , b) {\displaystyle f(x,b)} к фактическим значениям y {\displaystyle y} . Фактически это сводится к случаю «решения» переопределенной системы уравнений относительно b {\displaystyle b} :

F (x t , b) = y t , t = 1 , … , n {\displaystyle f(x_{t},b)=y_{t},t=1,\ldots ,n} .

В регрессионном анализе и в частности в эконометрике используются вероятностные модели зависимости между переменными

Y t = f (x t , b) + ε t {\displaystyle y_{t}=f(x_{t},b)+\varepsilon _{t}} ,

где ε t {\displaystyle \varepsilon _{t}} - так называемые случайные ошибки модели.

Соответственно, отклонения наблюдаемых значений y {\displaystyle y} от модельных f (x , b) {\displaystyle f(x,b)} предполагается уже в самой модели. Сущность МНК (обычного, классического) заключается в том, чтобы найти такие параметры b {\displaystyle b} , при которых сумма квадратов отклонений (ошибок, для регрессионных моделей их часто называют остатками регрессии) e t {\displaystyle e_{t}} будет минимальной:

b ^ O L S = arg min b R S S (b) {\displaystyle {\hat {b}}_{OLS}=\arg \min _{b}RSS(b)} ,где R S S {\displaystyle RSS} - англ. Residual Sum of Squares определяется как:

R S S (b) = e T e = ∑ t = 1 n e t 2 = ∑ t = 1 n (y t − f (x t , b)) 2 {\displaystyle RSS(b)=e^{T}e=\sum _{t=1}^{n}e_{t}^{2}=\sum _{t=1}^{n}(y_{t}-f(x_{t},b))^{2}} .В общем случае решение этой задачи может осуществляться численными методами оптимизации (минимизации). В этом случае говорят о нелинейном МНК (NLS или NLLS - англ. Non-Linear Least Squares ). Во многих случаях можно получить аналитическое решение. Для решения задачи минимизации необходимо найти стационарные точки функции R S S (b) {\displaystyle RSS(b)} , продифференцировав её по неизвестным параметрам b {\displaystyle b} , приравняв производные к нулю и решив полученную систему уравнений:

∑ t = 1 n (y t − f (x t , b)) ∂ f (x t , b) ∂ b = 0 {\displaystyle \sum _{t=1}^{n}(y_{t}-f(x_{t},b)){\frac {\partial f(x_{t},b)}{\partial b}}=0} .МНК в случае линейной регрессии

Пусть регрессионная зависимость является линейной:

y t = ∑ j = 1 k b j x t j + ε = x t T b + ε t {\displaystyle y_{t}=\sum _{j=1}^{k}b_{j}x_{tj}+\varepsilon =x_{t}^{T}b+\varepsilon _{t}} .Пусть y - вектор-столбец наблюдений объясняемой переменной, а X {\displaystyle X} - это (n × k) {\displaystyle ({n\times k})} -матрица наблюдений факторов (строки матрицы - векторы значений факторов в данном наблюдении, по столбцам - вектор значений данного фактора во всех наблюдениях). Матричное представление линейной модели имеет вид:

y = X b + ε {\displaystyle y=Xb+\varepsilon } .Тогда вектор оценок объясняемой переменной и вектор остатков регрессии будут равны

y ^ = X b , e = y − y ^ = y − X b {\displaystyle {\hat {y}}=Xb,\quad e=y-{\hat {y}}=y-Xb} .соответственно сумма квадратов остатков регрессии будет равна

R S S = e T e = (y − X b) T (y − X b) {\displaystyle RSS=e^{T}e=(y-Xb)^{T}(y-Xb)} .Дифференцируя эту функцию по вектору параметров b {\displaystyle b} и приравняв производные к нулю, получим систему уравнений (в матричной форме):

(X T X) b = X T y {\displaystyle (X^{T}X)b=X^{T}y} .В расшифрованной матричной форме эта система уравнений выглядит следующим образом:

(∑ x t 1 2 ∑ x t 1 x t 2 ∑ x t 1 x t 3 … ∑ x t 1 x t k ∑ x t 2 x t 1 ∑ x t 2 2 ∑ x t 2 x t 3 … ∑ x t 2 x t k ∑ x t 3 x t 1 ∑ x t 3 x t 2 ∑ x t 3 2 … ∑ x t 3 x t k ⋮ ⋮ ⋮ ⋱ ⋮ ∑ x t k x t 1 ∑ x t k x t 2 ∑ x t k x t 3 … ∑ x t k 2) (b 1 b 2 b 3 ⋮ b k) = (∑ x t 1 y t ∑ x t 2 y t ∑ x t 3 y t ⋮ ∑ x t k y t) , {\displaystyle {\begin{pmatrix}\sum x_{t1}^{2}&\sum x_{t1}x_{t2}&\sum x_{t1}x_{t3}&\ldots &\sum x_{t1}x_{tk}\\\sum x_{t2}x_{t1}&\sum x_{t2}^{2}&\sum x_{t2}x_{t3}&\ldots &\sum x_{t2}x_{tk}\\\sum x_{t3}x_{t1}&\sum x_{t3}x_{t2}&\sum x_{t3}^{2}&\ldots &\sum x_{t3}x_{tk}\\\vdots &\vdots &\vdots &\ddots &\vdots \\\sum x_{tk}x_{t1}&\sum x_{tk}x_{t2}&\sum x_{tk}x_{t3}&\ldots &\sum x_{tk}^{2}\\\end{pmatrix}}{\begin{pmatrix}b_{1}\\b_{2}\\b_{3}\\\vdots \\b_{k}\\\end{pmatrix}}={\begin{pmatrix}\sum x_{t1}y_{t}\\\sum x_{t2}y_{t}\\\sum x_{t3}y_{t}\\\vdots \\\sum x_{tk}y_{t}\\\end{pmatrix}},} где все суммы берутся по всем допустимым значениям t {\displaystyle t} .

Если в модель включена константа (как обычно), то x t 1 = 1 {\displaystyle x_{t1}=1} при всех t {\displaystyle t} , поэтому в левом верхнем углу матрицы системы уравнений находится количество наблюдений n {\displaystyle n} , а в остальных элементах первой строки и первого столбца - просто суммы значений переменных: ∑ x t j {\displaystyle \sum x_{tj}} и первый элемент правой части системы - ∑ y t {\displaystyle \sum y_{t}} .

Решение этой системы уравнений и дает общую формулу МНК-оценок для линейной модели:

b ^ O L S = (X T X) − 1 X T y = (1 n X T X) − 1 1 n X T y = V x − 1 C x y {\displaystyle {\hat {b}}_{OLS}=(X^{T}X)^{-1}X^{T}y=\left({\frac {1}{n}}X^{T}X\right)^{-1}{\frac {1}{n}}X^{T}y=V_{x}^{-1}C_{xy}} .Для аналитических целей оказывается полезным последнее представление этой формулы (в системе уравнений при делении на n, вместо сумм фигурируют средние арифметические). Если в регрессионной модели данные центрированы , то в этом представлении первая матрица имеет смысл выборочной ковариационной матрицы факторов, а вторая - вектор ковариаций факторов с зависимой переменной. Если кроме того данные ещё и нормированы на СКО (то есть в конечном итоге стандартизированы ), то первая матрица имеет смысл выборочной корреляционной матрицы факторов, второй вектор - вектора выборочных корреляций факторов с зависимой переменной.

Немаловажное свойство МНК-оценок для моделей с константой - линия построенной регрессии проходит через центр тяжести выборочных данных, то есть выполняется равенство:

y ¯ = b 1 ^ + ∑ j = 2 k b ^ j x ¯ j {\displaystyle {\bar {y}}={\hat {b_{1}}}+\sum _{j=2}^{k}{\hat {b}}_{j}{\bar {x}}_{j}} .В частности, в крайнем случае, когда единственным регрессором является константа, получаем, что МНК-оценка единственного параметра (собственно константы) равна среднему значению объясняемой переменной. То есть среднее арифметическое, известное своими хорошими свойствами из законов больших чисел, также является МНК-оценкой - удовлетворяет критерию минимума суммы квадратов отклонений от неё.

Простейшие частные случаи

В случае парной линейной регрессии y t = a + b x t + ε t {\displaystyle y_{t}=a+bx_{t}+\varepsilon _{t}} , когда оценивается линейная зависимость одной переменной от другой, формулы расчета упрощаются (можно обойтись без матричной алгебры). Система уравнений имеет вид:

(1 x ¯ x ¯ x 2 ¯) (a b) = (y ¯ x y ¯) {\displaystyle {\begin{pmatrix}1&{\bar {x}}\\{\bar {x}}&{\bar {x^{2}}}\\\end{pmatrix}}{\begin{pmatrix}a\\b\\\end{pmatrix}}={\begin{pmatrix}{\bar {y}}\\{\overline {xy}}\\\end{pmatrix}}} .Отсюда несложно найти оценки коэффициентов:

{ b ^ = Cov (x , y) Var (x) = x y ¯ − x ¯ y ¯ x 2 ¯ − x ¯ 2 , a ^ = y ¯ − b x ¯ . {\displaystyle {\begin{cases}{\hat {b}}={\frac {\mathop {\textrm {Cov}} (x,y)}{\mathop {\textrm {Var}} (x)}}={\frac {{\overline {xy}}-{\bar {x}}{\bar {y}}}{{\overline {x^{2}}}-{\overline {x}}^{2}}},\\{\hat {a}}={\bar {y}}-b{\bar {x}}.\end{cases}}}Несмотря на то что в общем случае модели с константой предпочтительней, в некоторых случаях из теоретических соображений известно, что константа a {\displaystyle a} должна быть равна нулю. Например, в физике зависимость между напряжением и силой тока имеет вид U = I ⋅ R {\displaystyle U=I\cdot R} ; замеряя напряжение и силу тока, необходимо оценить сопротивление. В таком случае речь идёт о модели y = b x {\displaystyle y=bx} . В этом случае вместо системы уравнений имеем единственное уравнение

(∑ x t 2) b = ∑ x t y t {\displaystyle \left(\sum x_{t}^{2}\right)b=\sum x_{t}y_{t}} .

Следовательно, формула оценки единственного коэффициента имеет вид

B ^ = ∑ t = 1 n x t y t ∑ t = 1 n x t 2 = x y ¯ x 2 ¯ {\displaystyle {\hat {b}}={\frac {\sum _{t=1}^{n}x_{t}y_{t}}{\sum _{t=1}^{n}x_{t}^{2}}}={\frac {\overline {xy}}{\overline {x^{2}}}}} .

Случай полиномиальной модели

Если данные аппроксимируются полиномиальной функцией регрессии одной переменной f (x) = b 0 + ∑ i = 1 k b i x i {\displaystyle f(x)=b_{0}+\sum \limits _{i=1}^{k}b_{i}x^{i}} , то, воспринимая степени x i {\displaystyle x^{i}} как независимые факторы для каждого i {\displaystyle i} можно оценить параметры модели исходя из общей формулы оценки параметров линейной модели. Для этого в общую формулу достаточно учесть, что при такой интерпретации x t i x t j = x t i x t j = x t i + j {\displaystyle x_{ti}x_{tj}=x_{t}^{i}x_{t}^{j}=x_{t}^{i+j}} и x t j y t = x t j y t {\displaystyle x_{tj}y_{t}=x_{t}^{j}y_{t}} . Следовательно, матричные уравнения в данном случае примут вид:

(n ∑ n x t … ∑ n x t k ∑ n x t ∑ n x i 2 … ∑ m x i k + 1 ⋮ ⋮ ⋱ ⋮ ∑ n x t k ∑ n x t k + 1 … ∑ n x t 2 k) [ b 0 b 1 ⋮ b k ] = [ ∑ n y t ∑ n x t y t ⋮ ∑ n x t k y t ] . {\displaystyle {\begin{pmatrix}n&\sum \limits _{n}x_{t}&\ldots &\sum \limits _{n}x_{t}^{k}\\\sum \limits _{n}x_{t}&\sum \limits _{n}x_{i}^{2}&\ldots &\sum \limits _{m}x_{i}^{k+1}\\\vdots &\vdots &\ddots &\vdots \\\sum \limits _{n}x_{t}^{k}&\sum \limits _{n}x_{t}^{k+1}&\ldots &\sum \limits _{n}x_{t}^{2k}\end{pmatrix}}{\begin{bmatrix}b_{0}\\b_{1}\\\vdots \\b_{k}\end{bmatrix}}={\begin{bmatrix}\sum \limits _{n}y_{t}\\\sum \limits _{n}x_{t}y_{t}\\\vdots \\\sum \limits _{n}x_{t}^{k}y_{t}\end{bmatrix}}.}

Статистические свойства МНК-оценок

В первую очередь, отметим, что для линейных моделей МНК-оценки являются линейными оценками, как это следует из вышеприведённой формулы. Для несмещенности МНК-оценок необходимо и достаточно выполнения важнейшего условия регрессионного анализа : условное по факторам математическое ожидание случайной ошибки должно быть равно нулю. Данное условие, в частности, выполнено, если

- математическое ожидание случайных ошибок равно нулю, и

- факторы и случайные ошибки - независимые случайные величины .

Второе условие - условие экзогенности факторов - принципиальное. Если это свойство не выполнено, то можно считать, что практически любые оценки будут крайне неудовлетворительными: они не будут даже состоятельными (то есть даже очень большой объём данных не позволяет получить качественные оценки в этом случае). В классическом случае делается более сильное предположение о детерминированности факторов, в отличие от случайной ошибки, что автоматически означает выполнение условия экзогенности. В общем случае для состоятельности оценок достаточно выполнения условия экзогенности вместе со сходимостью матрицы V x {\displaystyle V_{x}} к некоторой невырожденной матрице при увеличении объёма выборки до бесконечности.

Для того, чтобы кроме состоятельности и несмещенности , оценки (обычного) МНК были ещё и эффективными (наилучшими в классе линейных несмещенных оценок) необходимо выполнение дополнительных свойств случайной ошибки:

Данные предположения можно сформулировать для ковариационной матрицы вектора случайных ошибок V (ε) = σ 2 I {\displaystyle V(\varepsilon)=\sigma ^{2}I} .

Линейная модель, удовлетворяющая таким условиям, называется классической . МНК-оценки для классической линейной регрессии являются несмещёнными , состоятельными и наиболее эффективными оценками в классе всех линейных несмещённых оценок (в англоязычной литературе иногда употребляют аббревиатуру BLUE (Best Linear Unbiased Estimator ) - наилучшая линейная несмещённая оценка; в отечественной литературе чаще приводится теорема Гаусса - Маркова). Как нетрудно показать, ковариационная матрица вектора оценок коэффициентов будет равна:

V (b ^ O L S) = σ 2 (X T X) − 1 {\displaystyle V({\hat {b}}_{OLS})=\sigma ^{2}(X^{T}X)^{-1}} .

Эффективность означает, что эта ковариационная матрица является «минимальной» (любая линейная комбинация коэффициентов, и в частности сами коэффициенты, имеют минимальную дисперсию), то есть в классе линейных несмещенных оценок оценки МНК-наилучшие. Диагональные элементы этой матрицы - дисперсии оценок коэффициентов - важные параметры качества полученных оценок. Однако рассчитать ковариационную матрицу невозможно, поскольку дисперсия случайных ошибок неизвестна. Можно доказать, что несмещённой и состоятельной (для классической линейной модели) оценкой дисперсии случайных ошибок является величина:

S 2 = R S S / (n − k) {\displaystyle s^{2}=RSS/(n-k)} .

Подставив данное значение в формулу для ковариационной матрицы и получим оценку ковариационной матрицы. Полученные оценки также являются несмещёнными и состоятельными . Важно также то, что оценка дисперсии ошибок (а значит и дисперсий коэффициентов) и оценки параметров модели являются независимыми случайными величинами, что позволяет получить тестовые статистики для проверки гипотез о коэффициентах модели.

Необходимо отметить, что если классические предположения не выполнены, МНК-оценки параметров не являются наиболее эффективными и, где W {\displaystyle W} - некоторая симметрическая положительно определенная весовая матрица. Обычный МНК является частным случаем данного подхода, когда весовая матрица пропорциональна единичной матрице. Как известно, для симметрических матриц (или операторов) существует разложение W = P T P {\displaystyle W=P^{T}P} . Следовательно, указанный функционал можно представить следующим образом e T P T P e = (P e) T P e = e ∗ T e ∗ {\displaystyle e^{T}P^{T}Pe=(Pe)^{T}Pe=e_{*}^{T}e_{*}} , то есть этот функционал можно представить как сумму квадратов некоторых преобразованных «остатков». Таким образом, можно выделить класс методов наименьших квадратов - LS-методы (Least Squares).

Доказано (теорема Айткена), что для обобщенной линейной регрессионной модели (в которой на ковариационную матрицу случайных ошибок не налагается никаких ограничений) наиболее эффективными (в классе линейных несмещенных оценок) являются оценки т. н. обобщенного МНК (ОМНК, GLS - Generalized Least Squares) - LS-метода с весовой матрицей, равной обратной ковариационной матрице случайных ошибок: W = V ε − 1 {\displaystyle W=V_{\varepsilon }^{-1}} .

Можно показать, что формула ОМНК-оценок параметров линейной модели имеет вид

B ^ G L S = (X T V − 1 X) − 1 X T V − 1 y {\displaystyle {\hat {b}}_{GLS}=(X^{T}V^{-1}X)^{-1}X^{T}V^{-1}y} .

Ковариационная матрица этих оценок соответственно будет равна

V (b ^ G L S) = (X T V − 1 X) − 1 {\displaystyle V({\hat {b}}_{GLS})=(X^{T}V^{-1}X)^{-1}} .

Фактически сущность ОМНК заключается в определенном (линейном) преобразовании (P) исходных данных и применении обычного МНК к преобразованным данным. Цель этого преобразования - для преобразованных данных случайные ошибки уже удовлетворяют классическим предположениям.

Взвешенный МНК

В случае диагональной весовой матрицы (а значит и ковариационной матрицы случайных ошибок) имеем так называемый взвешенный МНК (WLS - Weighted Least Squares). В данном случае минимизируется взвешенная сумма квадратов остатков модели, то есть каждое наблюдение получает «вес», обратно пропорциональный дисперсии случайной ошибки в данном наблюдении: e T W e = ∑ t = 1 n e t 2 σ t 2 {\displaystyle e^{T}We=\sum _{t=1}^{n}{\frac {e_{t}^{2}}{\sigma _{t}^{2}}}} . Фактически данные преобразуются взвешиванием наблюдений (делением на величину, пропорциональную предполагаемому стандартному отклонению случайных ошибок), а к взвешенным данным применяется обычный МНК.

ISBN 978-5-7749-0473-0 .